Видеокарта GeForce FX5500 PCI. Когда не хватает PCI-Express

- Цена: $16.99

- Перейти в магазин

В наше время купить второй и/или третий монитор для ПК не проблема — стоят подержанные комплектующие недорого.

А вот с их подключением всё уже не так просто, особенно если сам ПК далеко не первой свежести: на встроенных в материнскую плату видеокартах второй выход может отсутствовать, PCI-E разъёмы — оказаться в дефиците, конвертеры USB3.0-VGA или USB3.0-HDMI — неприменимы из-за отсутствия самой USB3.0, а их аналоги для USB2.0 — дороже самой материнской платы.

В этом случае проблему может решить…

… использование видеокарты PCI.

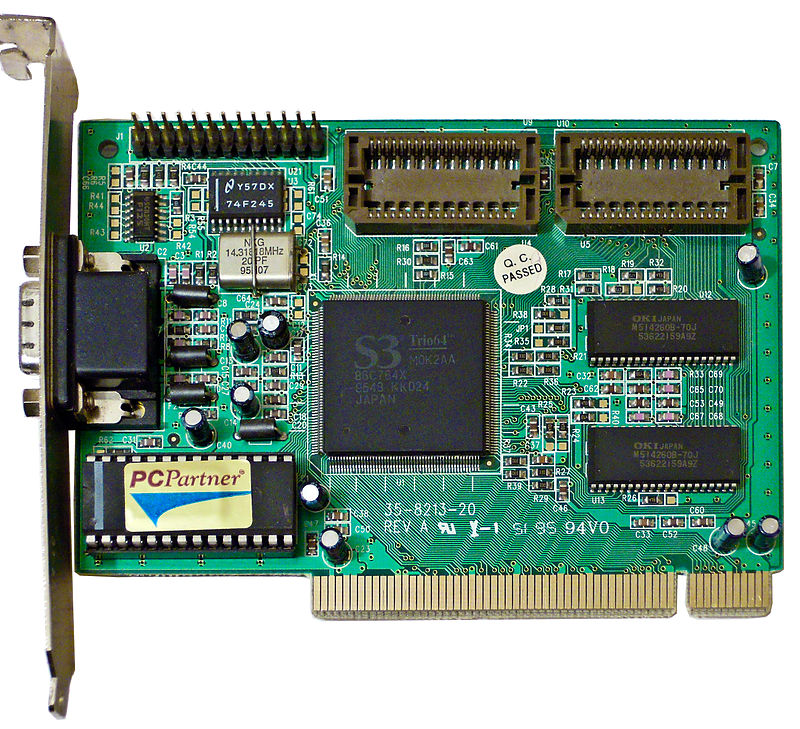

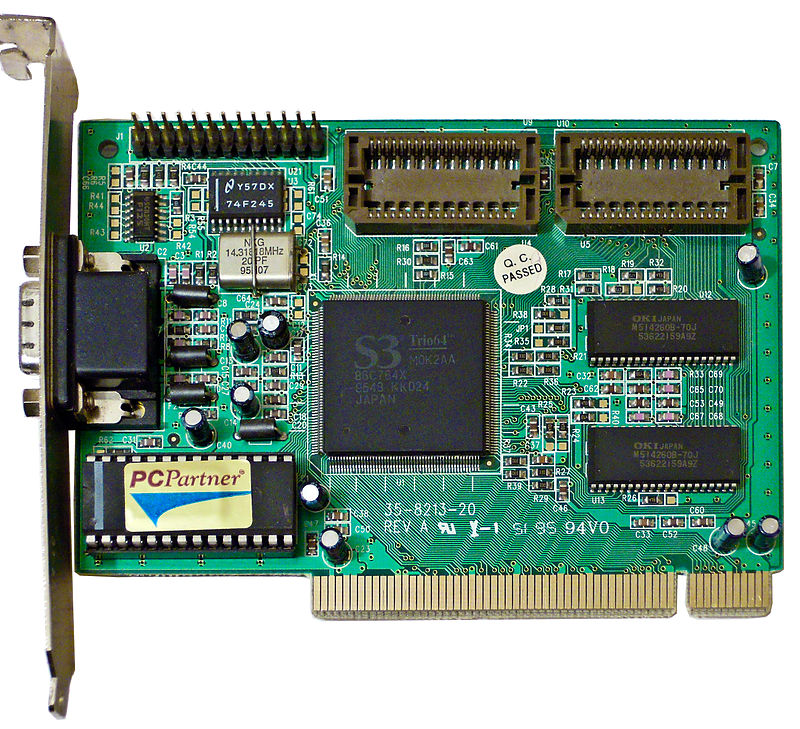

Обычно при этих словах представляется нечто уровня S3 Trio с объёмом памяти в 1-2 мегабайта, практически беспомощное по современным меркам.

На самом деле выбор этим далеко не ограничивается.

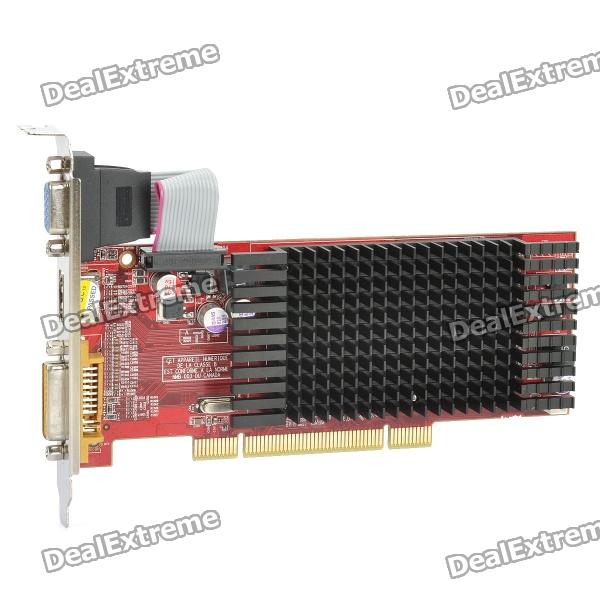

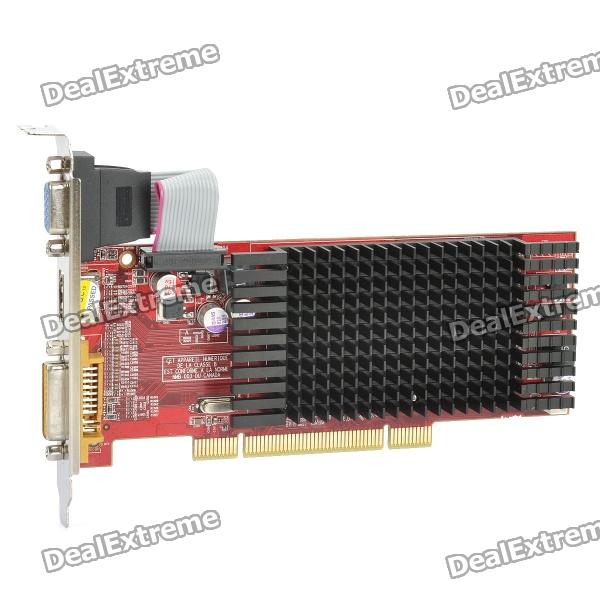

Казалось бы, звезда PCI видеокарт закатилась окончательно и бесповоротно в конце 1990-х, но на самом деле это не так. Самая продвинутая из известных мне таких плат — ATI Radeon HD5450 с 2 гигабайтами DDR3.

Вполне пригодится тем, кто хочет выжать из своего компа еще чуть-чуть, а свободных слотов расширения PCI-E не осталось(в том числе и за счёт того, что PCI лучше переносит разгон компьютера). На мой взгляд, чувствуется некоторая ирония в том, что видеокарты, оснащенные медлительным интерфейсом PCI, пережили стандарт AGP, который в свое время был предложен именно для решения проблемы «бутылочного горлышка» графической подсистемы.

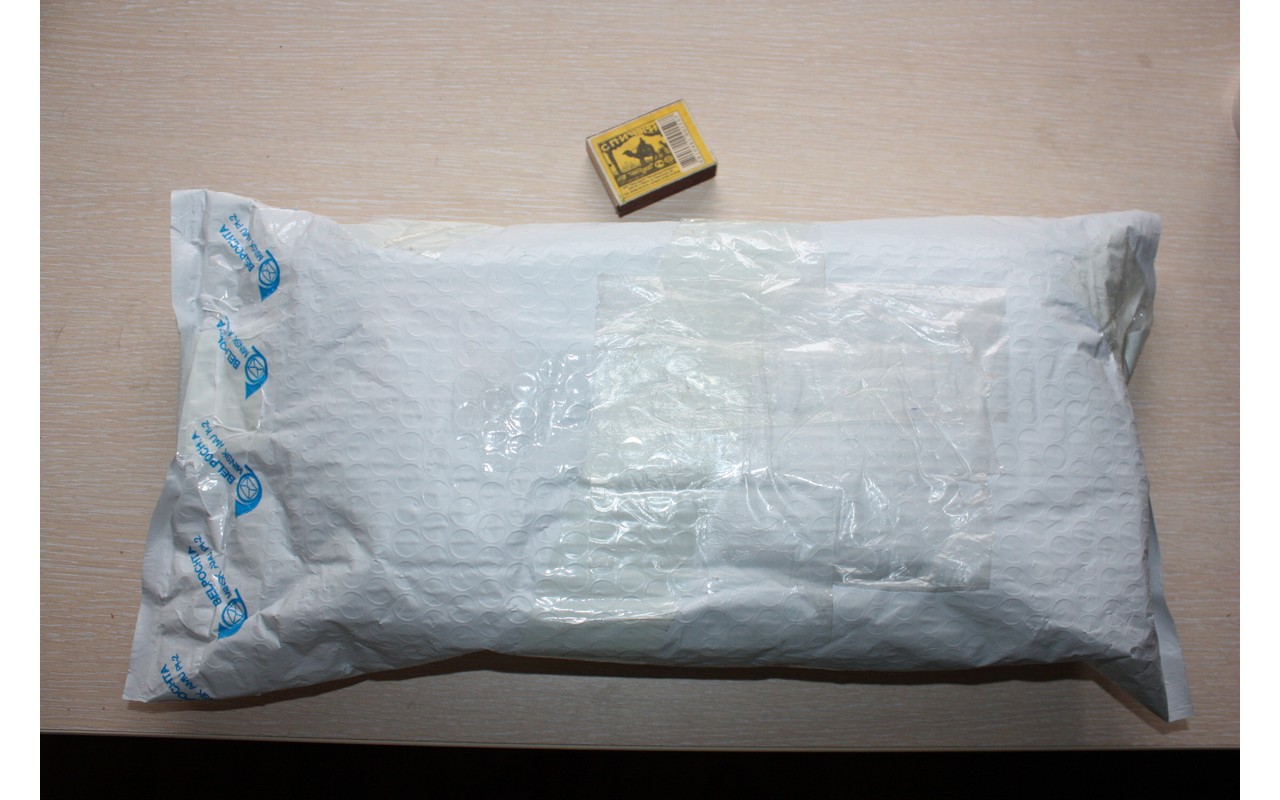

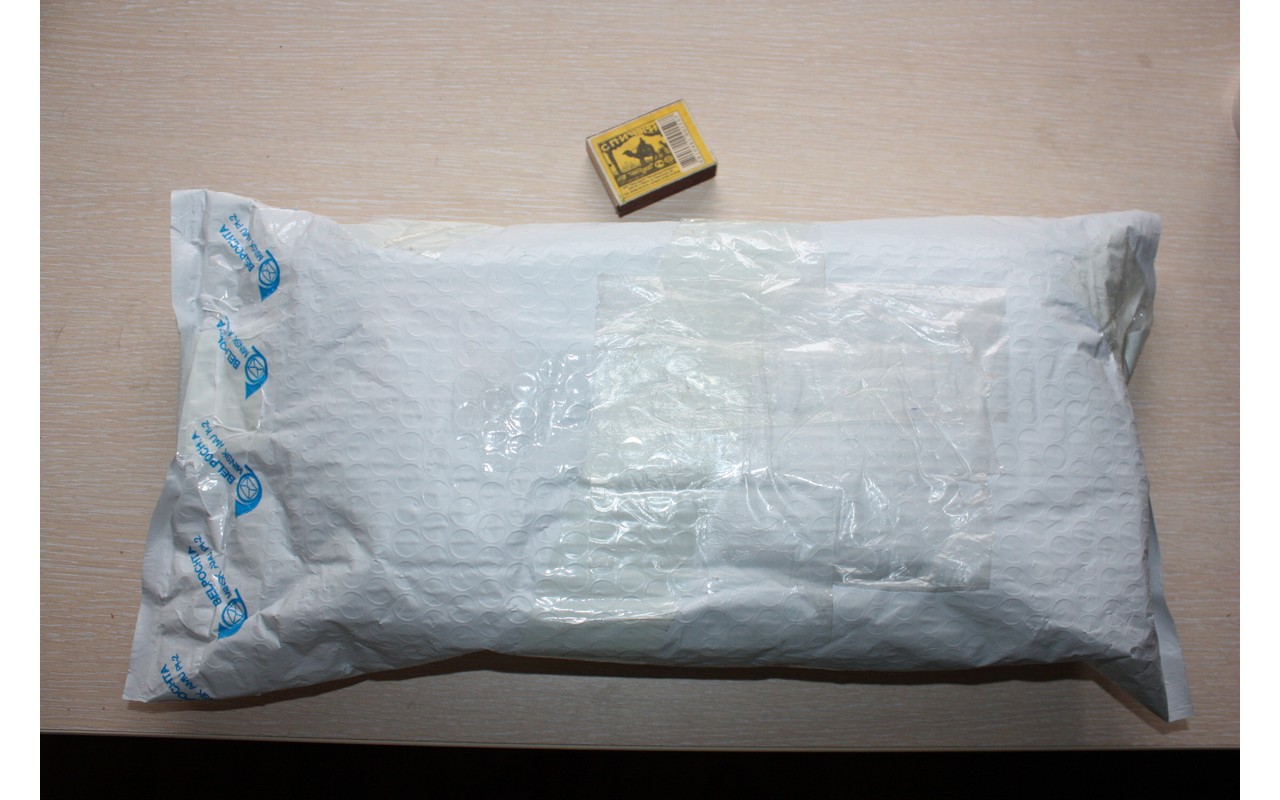

Заказанная видеокарта приехала в большом пакете из пупырки голландской почтой всего за 8 дней — почти рекорд.

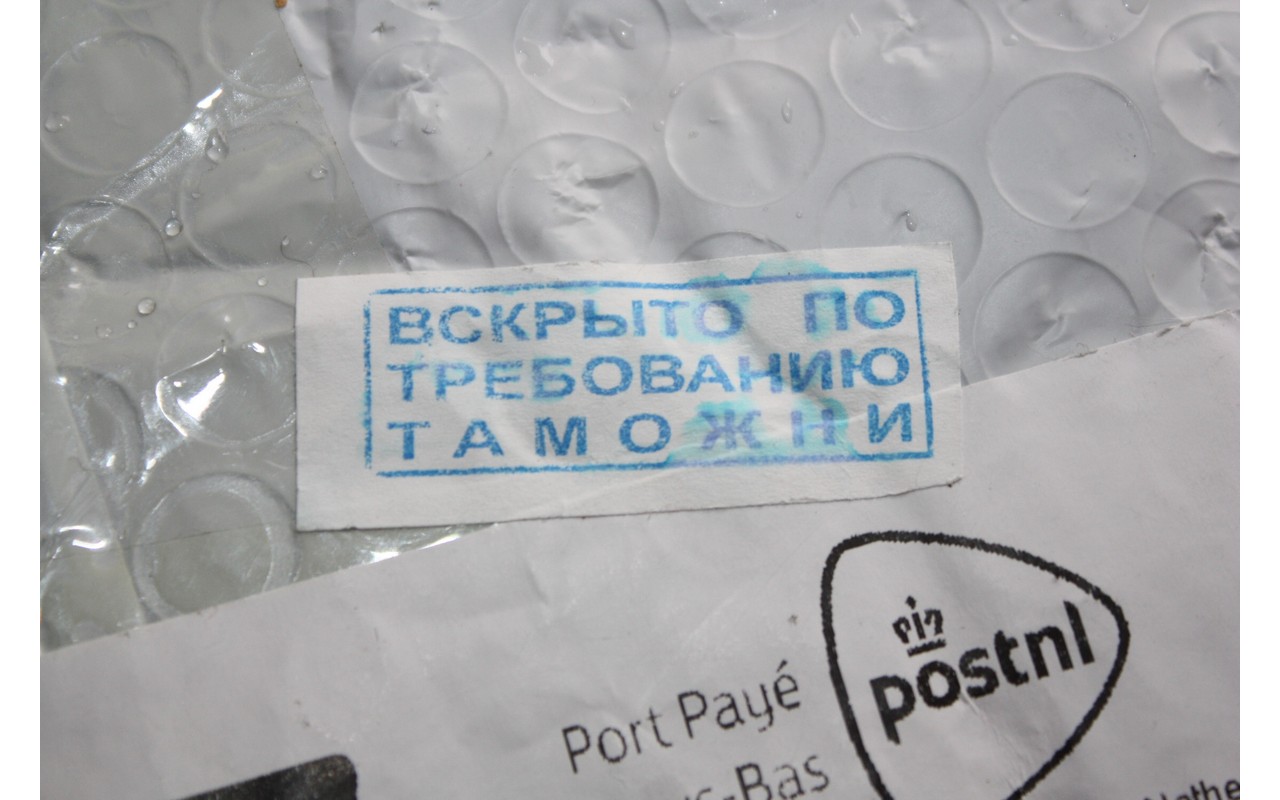

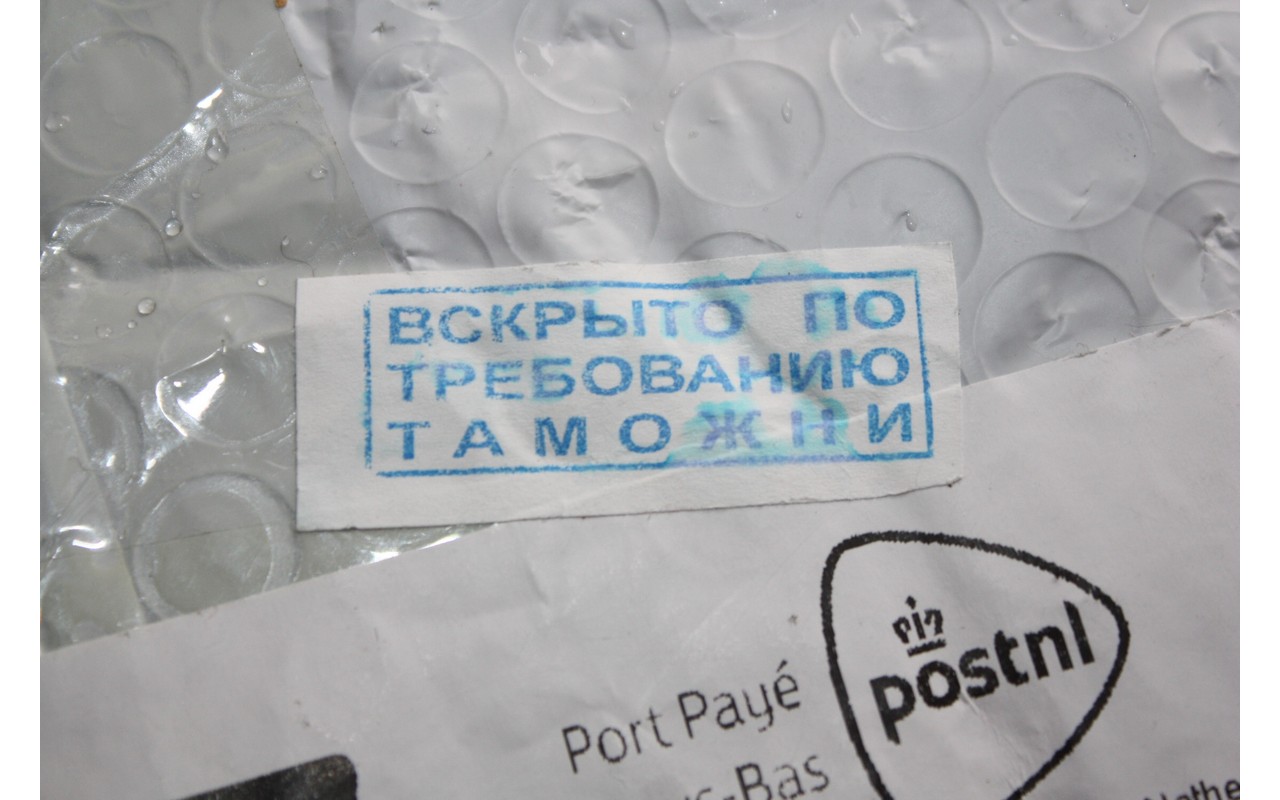

К сожалению, таможенников возбудил факт наличия в посылке видеокарты как таковой, и они решили её вскрыть. Наверное, наслушались историй про майнинг криптовалют?

Зря старались — майнить на ней нельзя. И очень, судя по всему, от этого расстроились.

Плата была упакована в картонную коробку довольно неинформативного вида.

Из всех надписей на коробке правдой оказалось только то, что это GeForce и что оно совместимо с Windows 7.

Внутри коробки лежат видеокарта, упакованная в антистатический пакет, и компакт-диск с драйверами.

Переходника DVI-VGA нет.

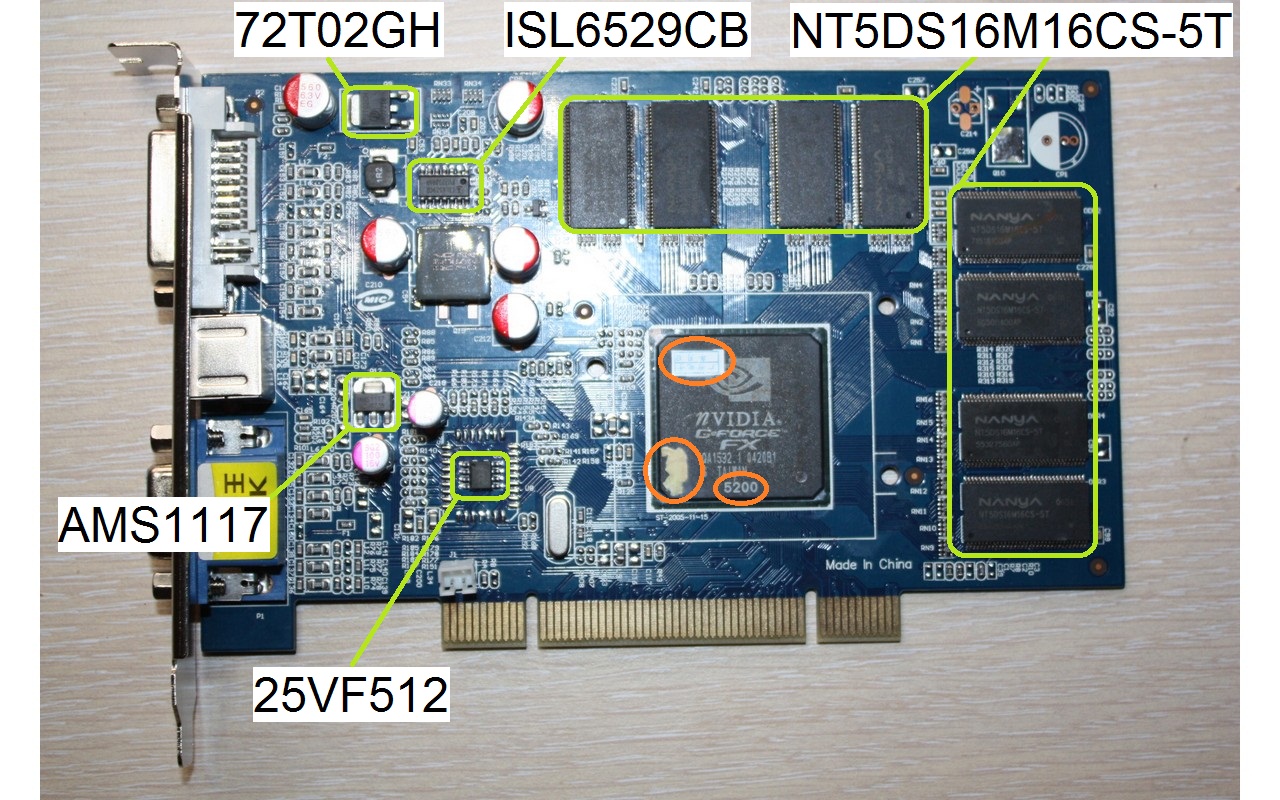

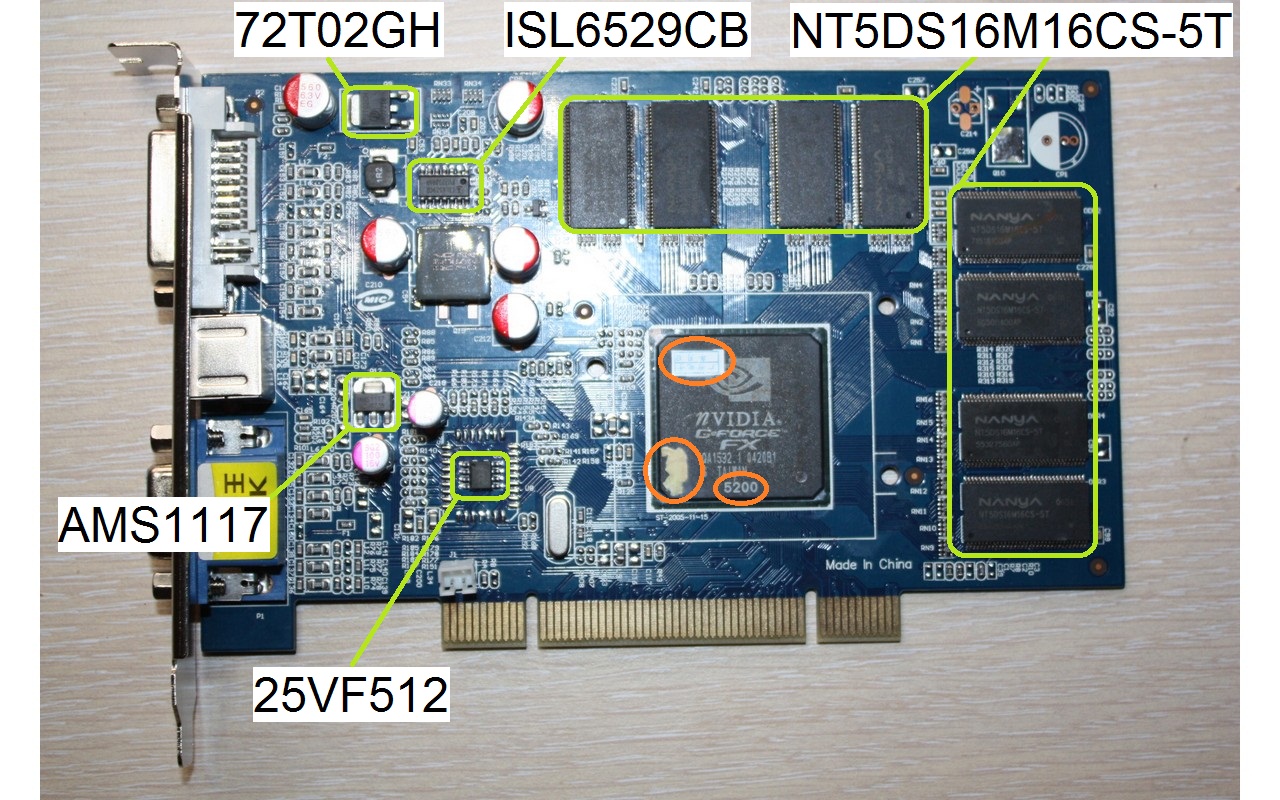

Больше половины передней стороны печатной платы закрыто радиатором. Имеются выходы VGA, S-Video и DVI-I.

Между ним и видеоядром находится термопаста.

А на чипах памяти её нет, да и вообще отводу тепла от них радиатор только мешает.

Оребрение у него по сути чисто декоративное, поэтому его рекомендуется заменить.

Например, на радиатор чипсета от старой материнской платы.

Он даже по креплениям прекрасно совпадает.

Ради интереса я решил отмыть ядро от термопасты, и тут меня ждал сюрприз.

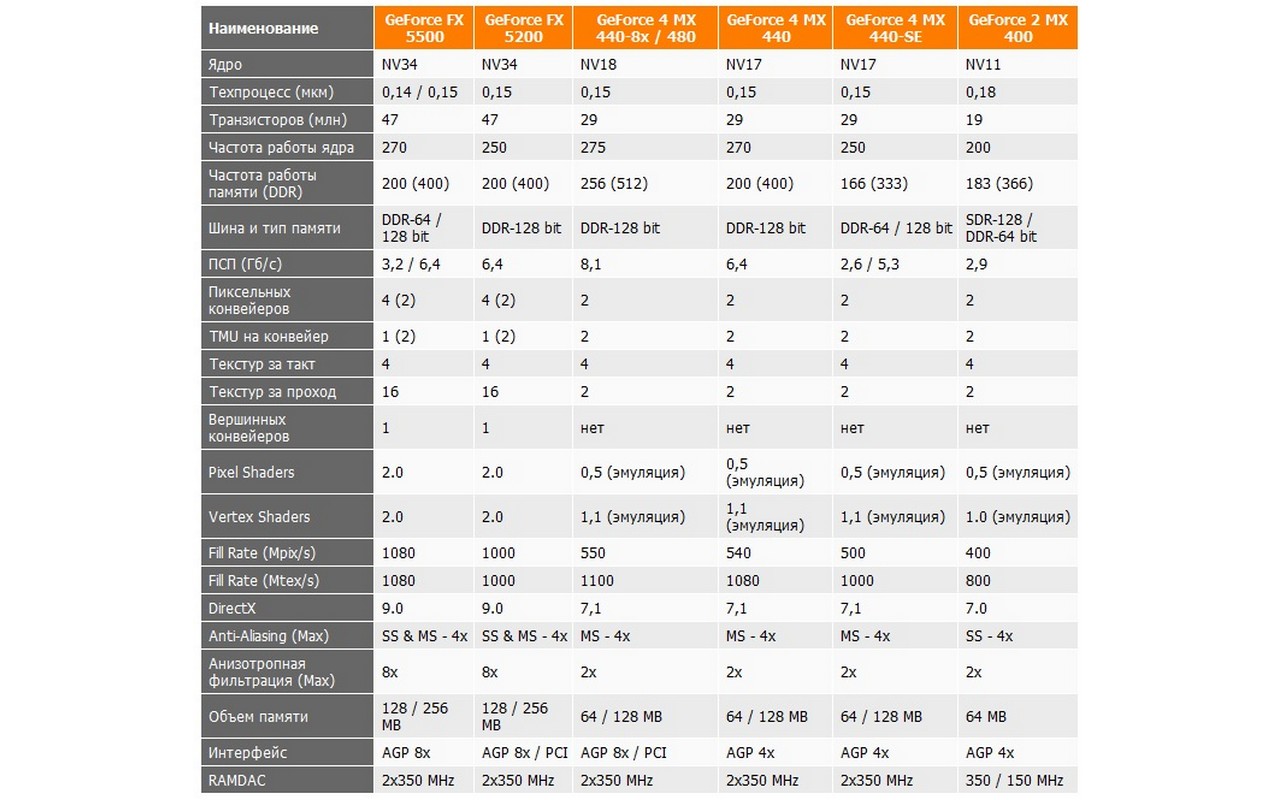

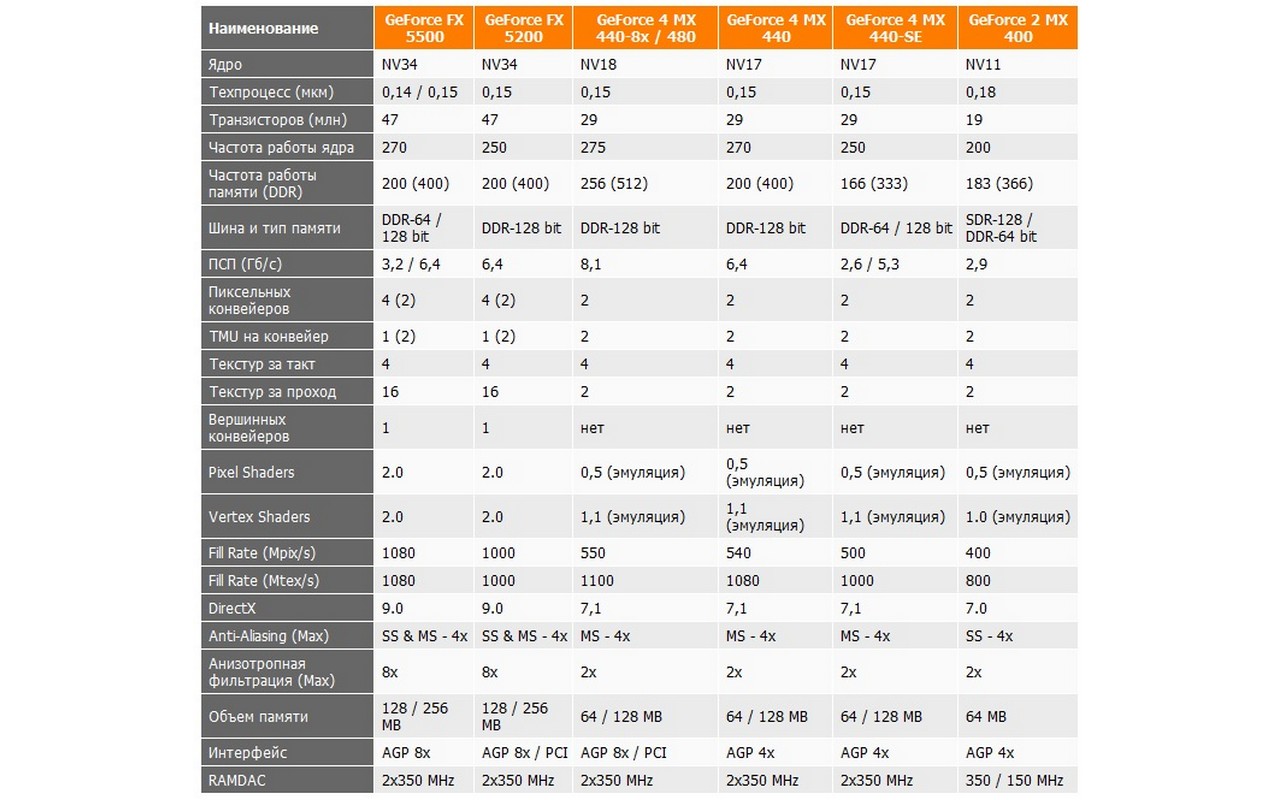

Впрочем, единственная разница между FX5500 и FX5200 — это немного отличающиеся рабочие частоты, что в наше время применительно к DirectX 9 видеокарте может представлять исключительно академический интерес(а для других есть PowerStrip).

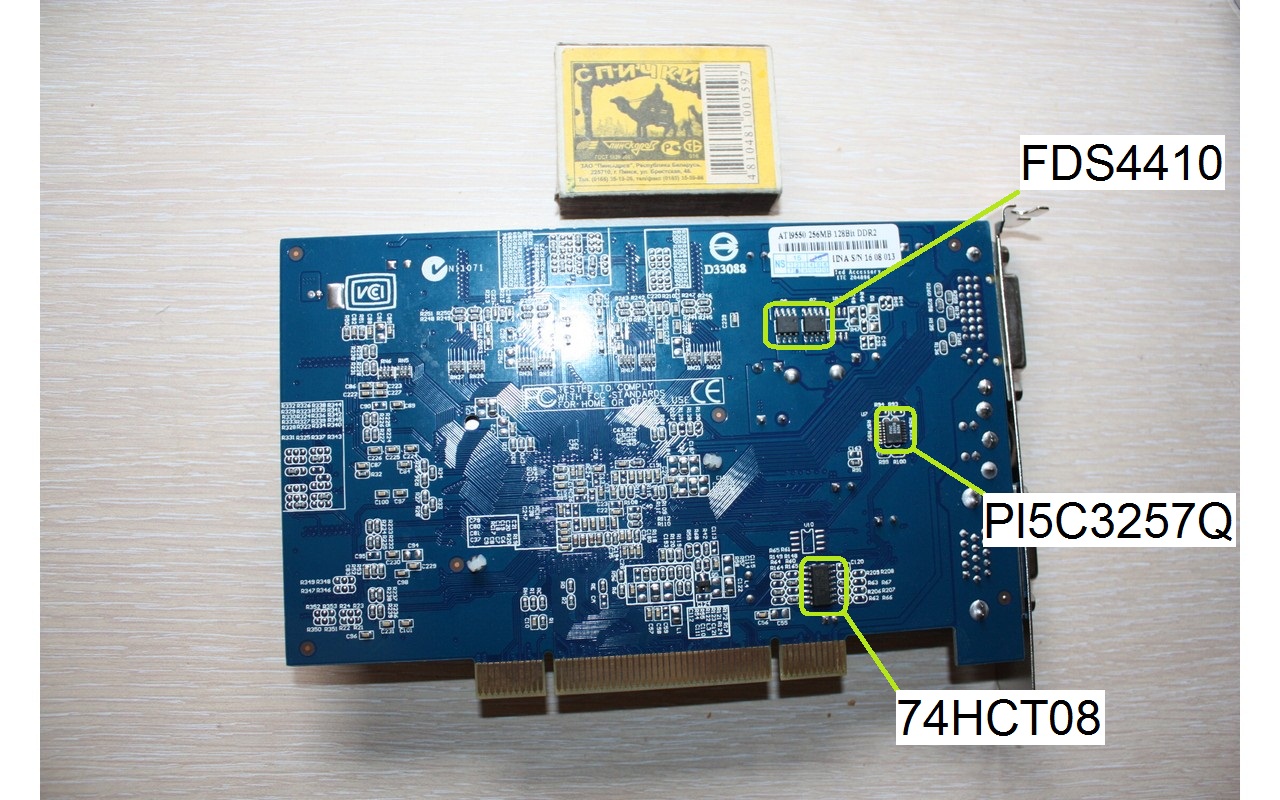

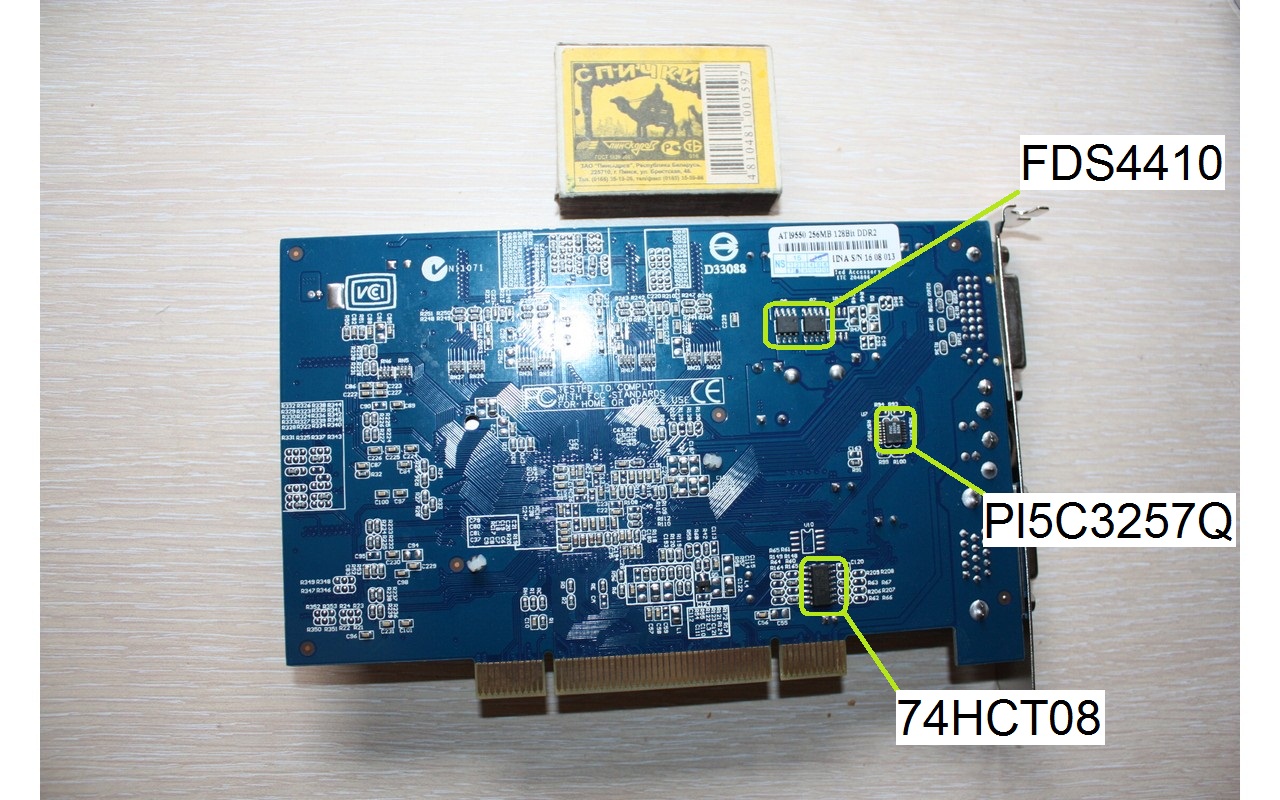

На обратной стороне платы деталей почти нет, зато есть наклеечка с датой изготовления. Если верить ей, то плата изготовлена в августе 2016 года. А ещё там есть наклеечка, утверждающая, что плата на самом деле ATI Radeon 9550.

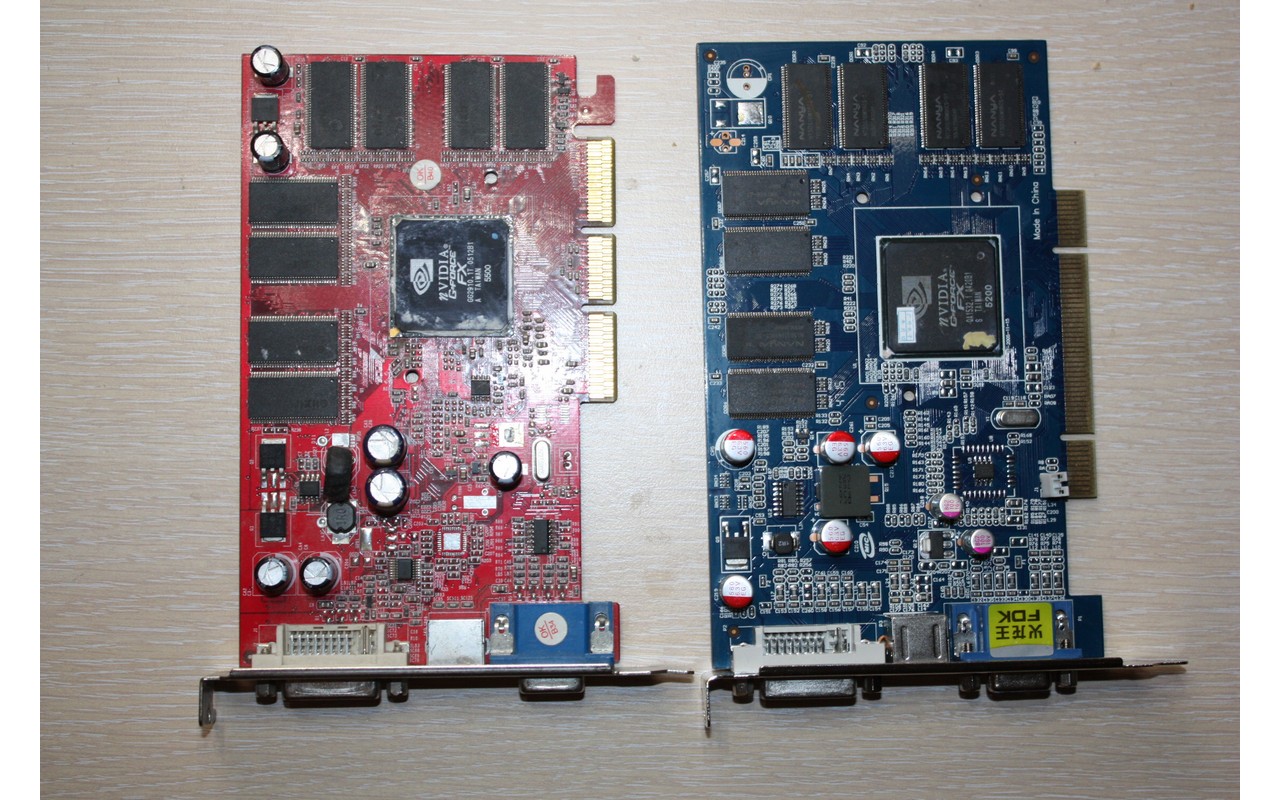

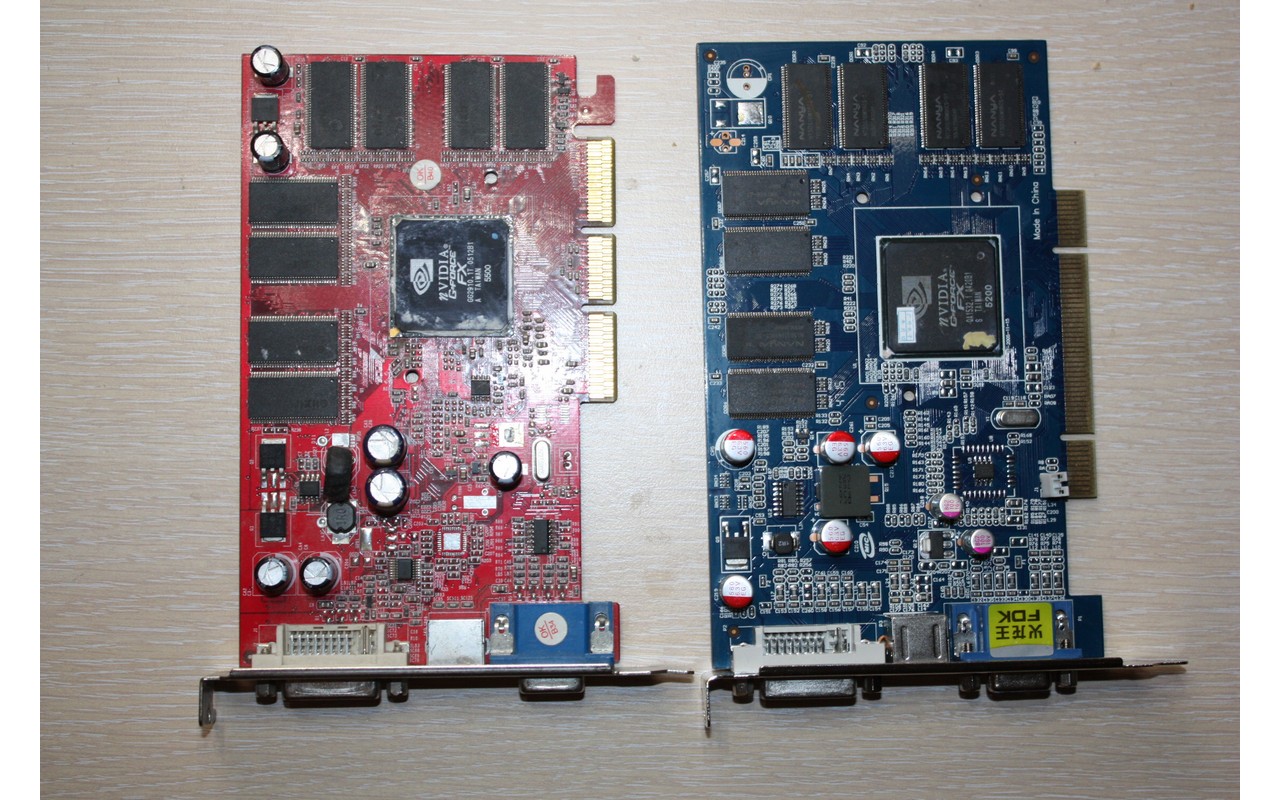

Чувствуется фамильное сходство, не так ли?

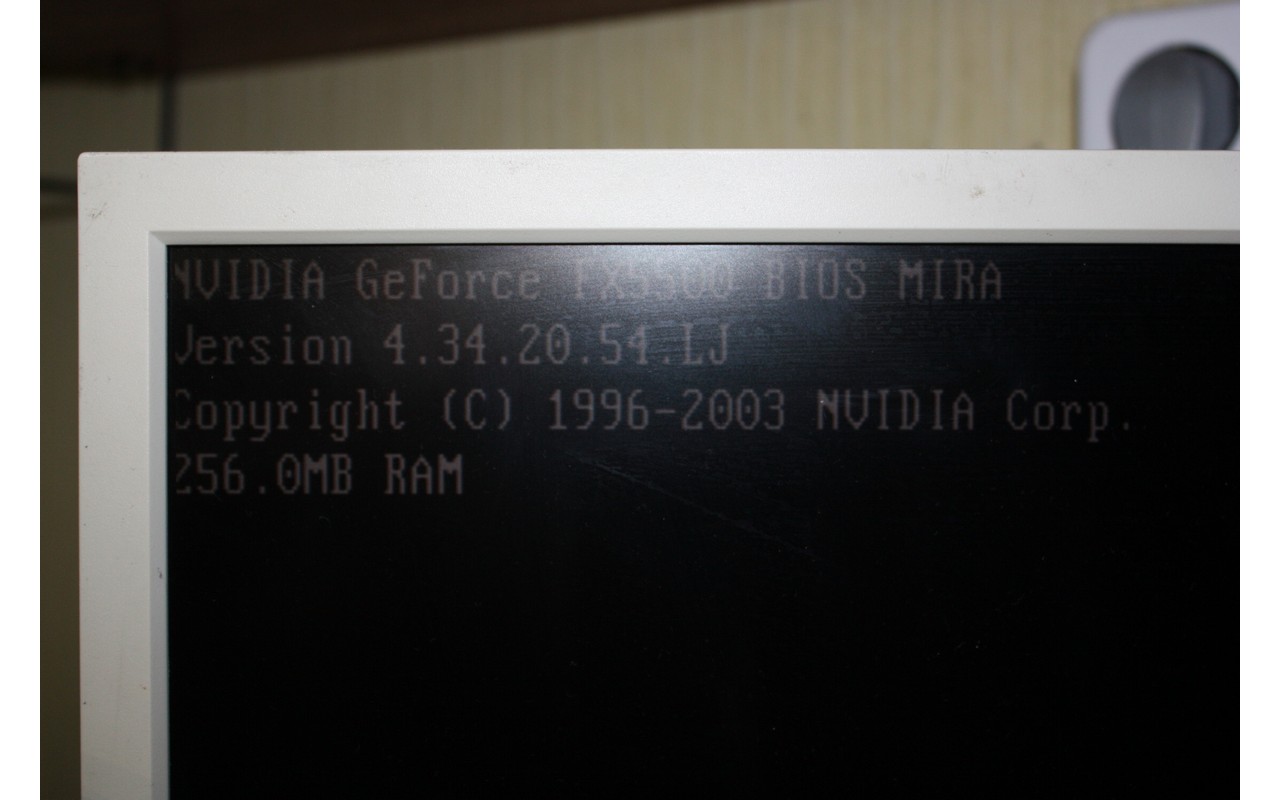

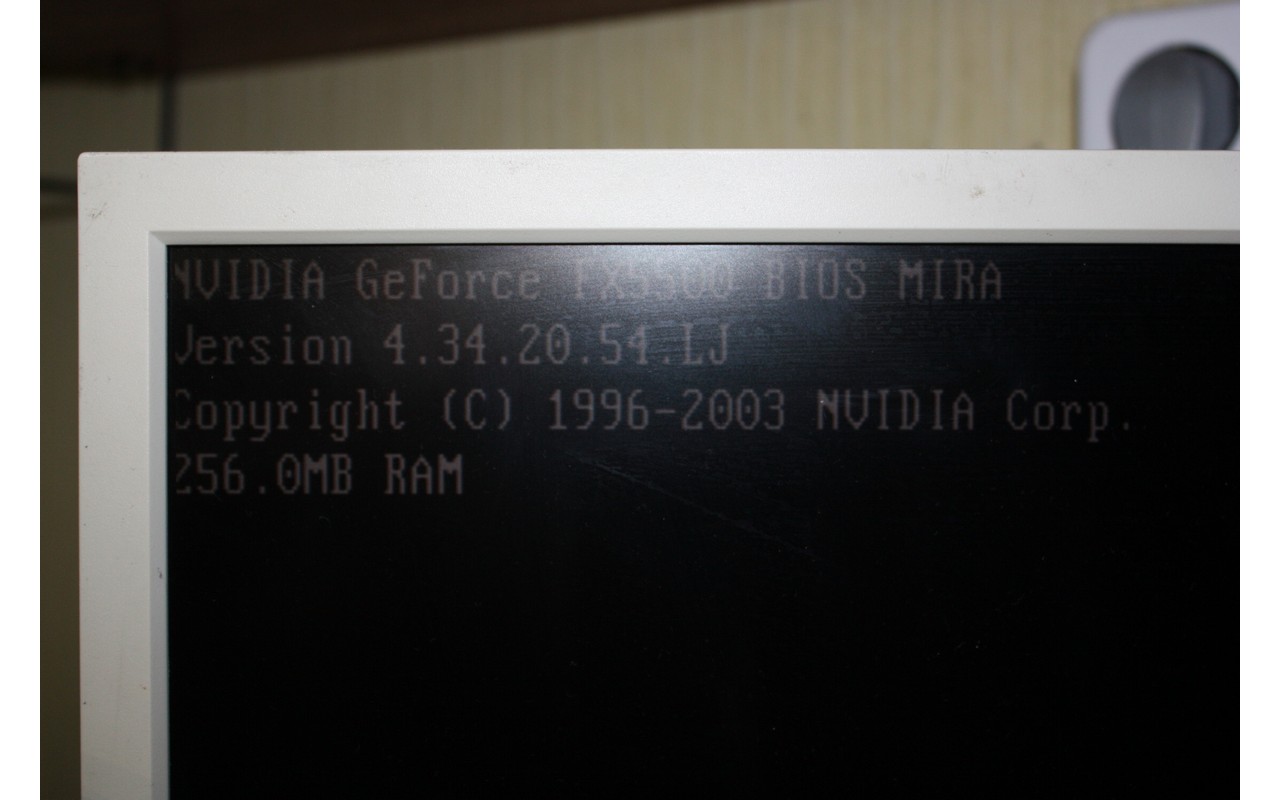

При подключении двух мониторов плата предварительно инициализирует тот, который подключен к VGA, но в дальнейшем считает основным подключенный к DVI.

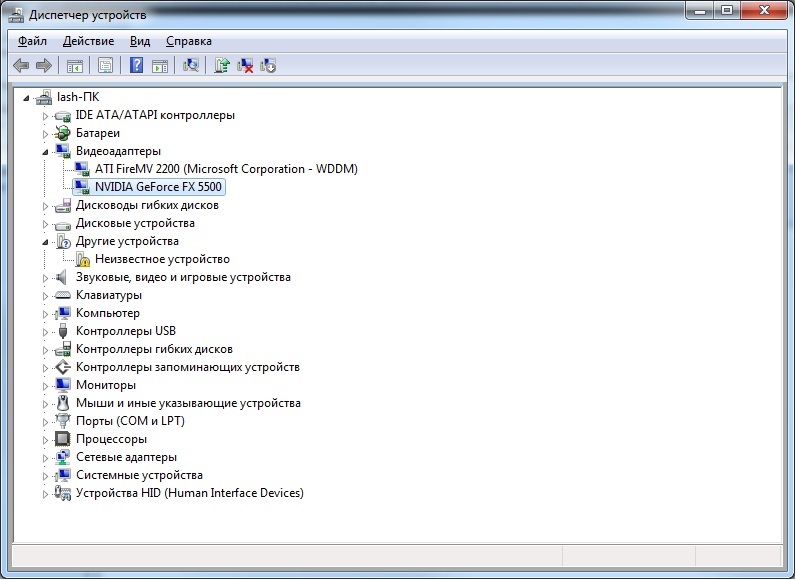

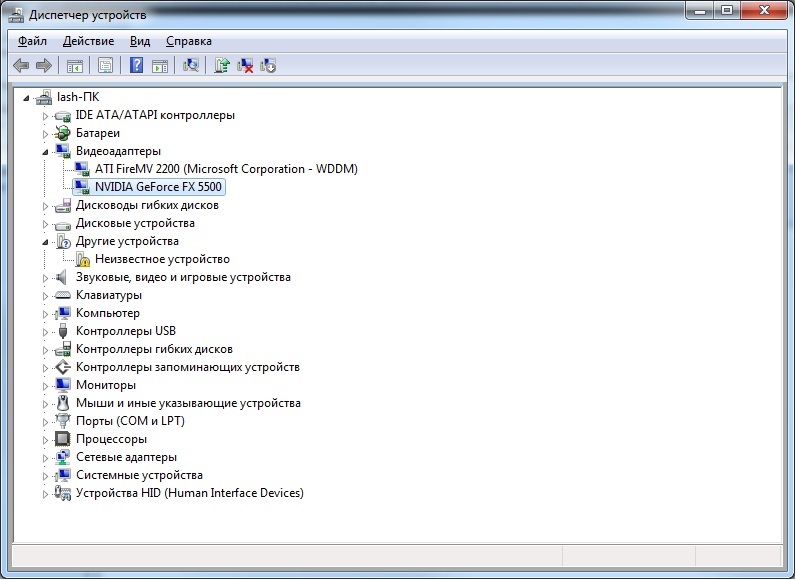

Драйвера устанавливаются нормально, карта появляется в диспетчере устройств, после чего можно использовать расширение рабочего стола.

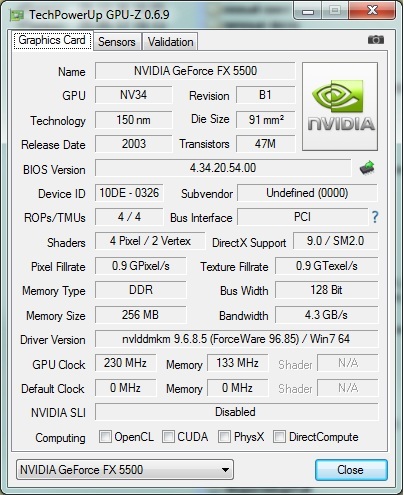

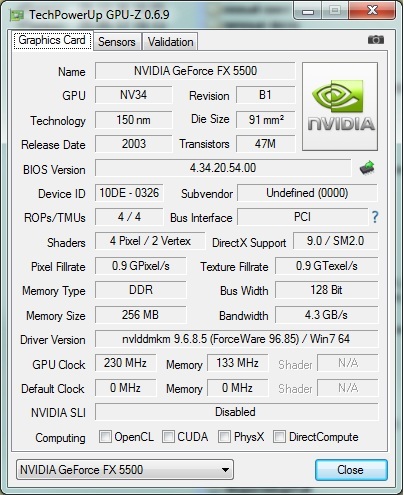

Параметры через GPU-Z вычитываются.

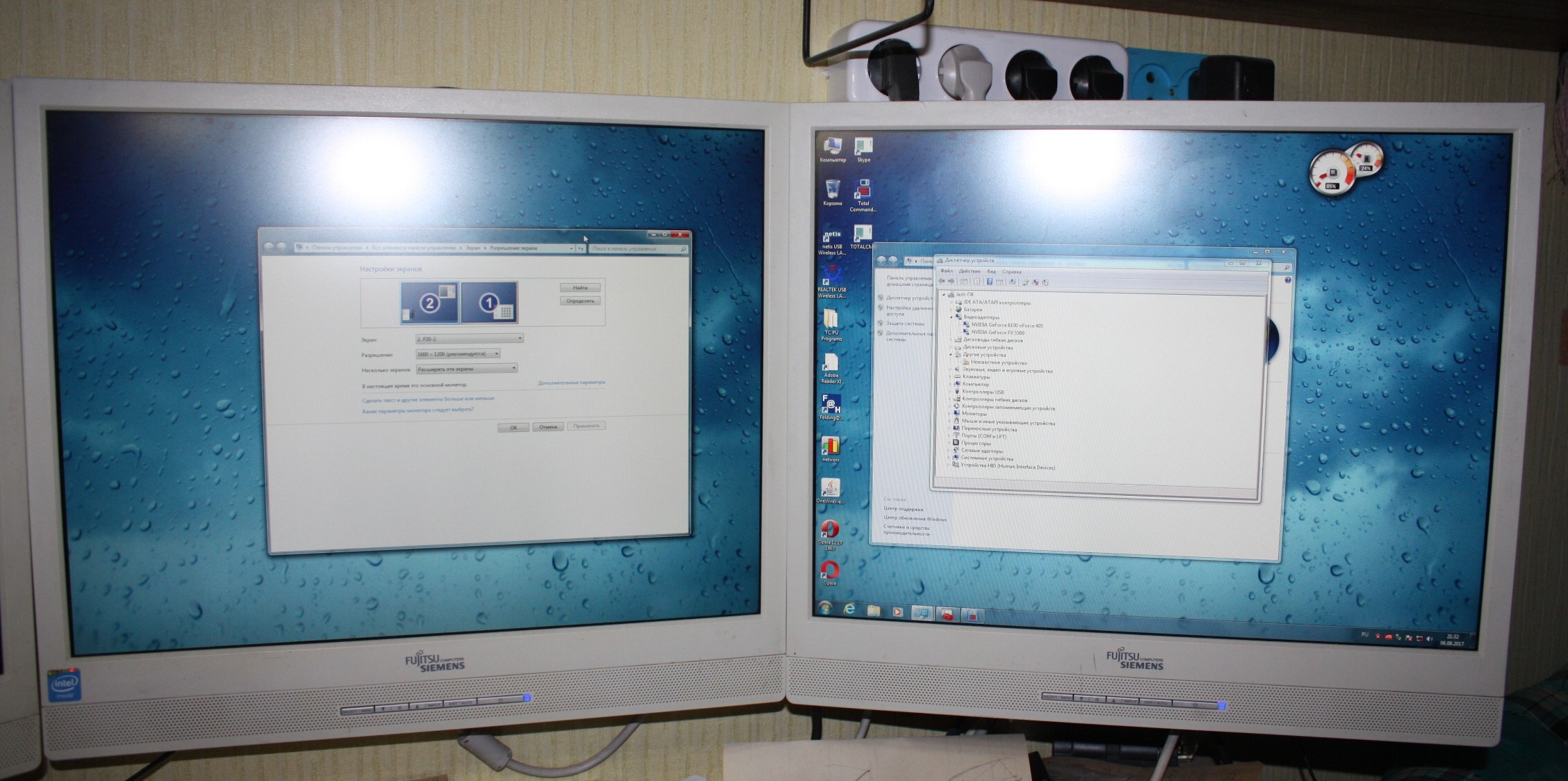

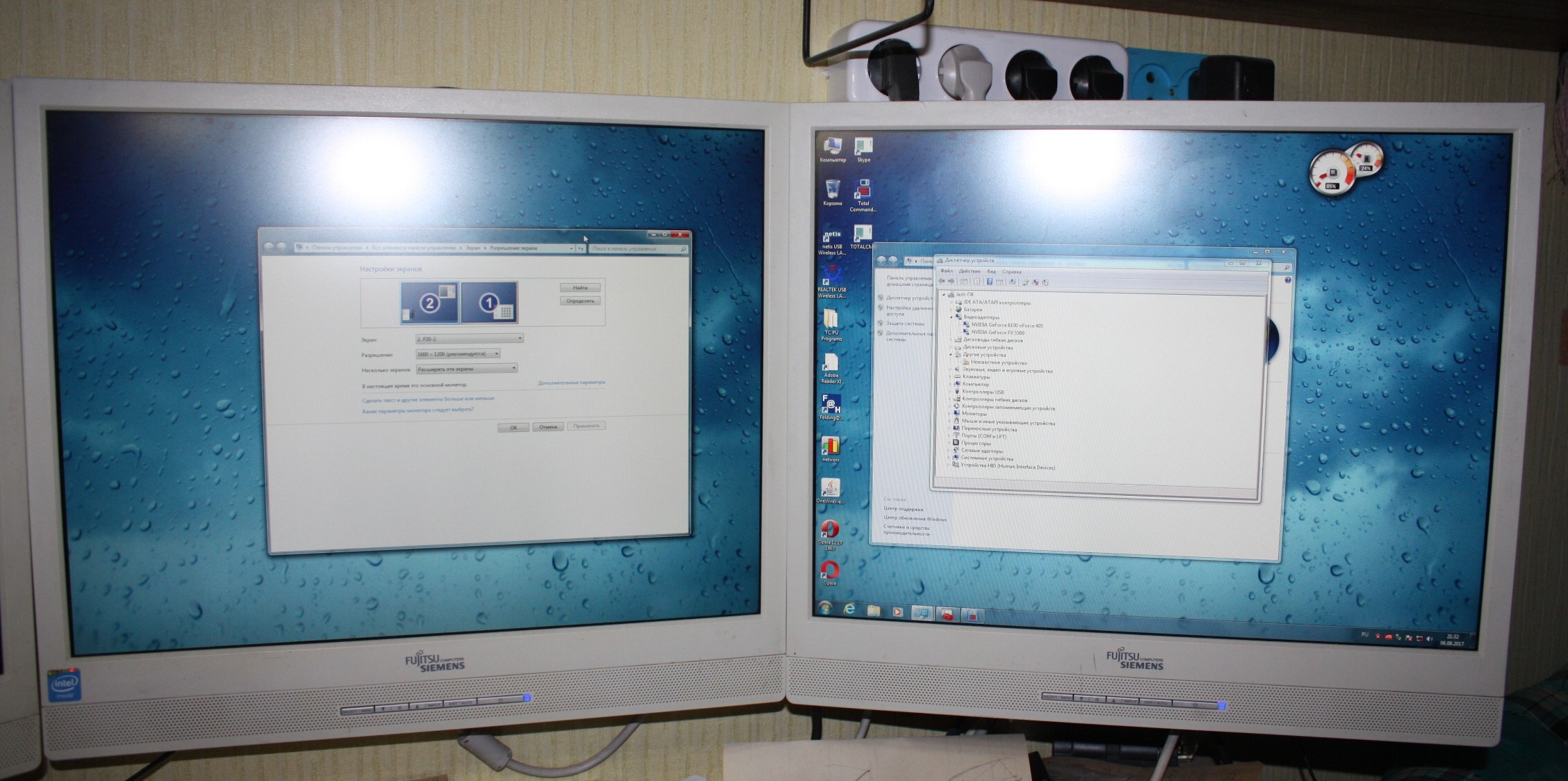

Пару рабочих столов в разрешении 1600х1200 при 32-битной глубине цвета видеокарта тянет.

По производительности плата 2003 года разработки примерно на уровне MX400, поэтому запускать на ней современные бенчмарки смысла нет — сейчас это просто два дополнительных видеовыхода в ПК.

Вывод: при цене чуть менее 17$ на момент покупки видеокарта вполне может заменить два конвертера USB2.0-VGA или USB2.0-DVI общей стоимостью 80-90$. Так что если нужно добавить пару видеовыходов, а PCI-E в дефиците, но есть свободные PCI — это неплохой вариант решения проблемы.

А вот с их подключением всё уже не так просто, особенно если сам ПК далеко не первой свежести: на встроенных в материнскую плату видеокартах второй выход может отсутствовать, PCI-E разъёмы — оказаться в дефиците, конвертеры USB3.0-VGA или USB3.0-HDMI — неприменимы из-за отсутствия самой USB3.0, а их аналоги для USB2.0 — дороже самой материнской платы.

В этом случае проблему может решить…

… использование видеокарты PCI.

Обычно при этих словах представляется нечто уровня S3 Trio с объёмом памяти в 1-2 мегабайта, практически беспомощное по современным меркам.

На самом деле выбор этим далеко не ограничивается.

Казалось бы, звезда PCI видеокарт закатилась окончательно и бесповоротно в конце 1990-х, но на самом деле это не так. Самая продвинутая из известных мне таких плат — ATI Radeon HD5450 с 2 гигабайтами DDR3.

Вполне пригодится тем, кто хочет выжать из своего компа еще чуть-чуть, а свободных слотов расширения PCI-E не осталось(в том числе и за счёт того, что PCI лучше переносит разгон компьютера). На мой взгляд, чувствуется некоторая ирония в том, что видеокарты, оснащенные медлительным интерфейсом PCI, пережили стандарт AGP, который в свое время был предложен именно для решения проблемы «бутылочного горлышка» графической подсистемы.

Заказанная видеокарта приехала в большом пакете из пупырки голландской почтой всего за 8 дней — почти рекорд.

К сожалению, таможенников возбудил факт наличия в посылке видеокарты как таковой, и они решили её вскрыть. Наверное, наслушались историй про майнинг криптовалют?

Зря старались — майнить на ней нельзя. И очень, судя по всему, от этого расстроились.

Плата была упакована в картонную коробку довольно неинформативного вида.

Из всех надписей на коробке правдой оказалось только то, что это GeForce и что оно совместимо с Windows 7.

Внутри коробки лежат видеокарта, упакованная в антистатический пакет, и компакт-диск с драйверами.

Переходника DVI-VGA нет.

Больше половины передней стороны печатной платы закрыто радиатором. Имеются выходы VGA, S-Video и DVI-I.

Между ним и видеоядром находится термопаста.

А на чипах памяти её нет, да и вообще отводу тепла от них радиатор только мешает.

Оребрение у него по сути чисто декоративное, поэтому его рекомендуется заменить.

Например, на радиатор чипсета от старой материнской платы.

Он даже по креплениям прекрасно совпадает.

Ради интереса я решил отмыть ядро от термопасты, и тут меня ждал сюрприз.

Впрочем, единственная разница между FX5500 и FX5200 — это немного отличающиеся рабочие частоты, что в наше время применительно к DirectX 9 видеокарте может представлять исключительно академический интерес(а для других есть PowerStrip).

На обратной стороне платы деталей почти нет, зато есть наклеечка с датой изготовления. Если верить ей, то плата изготовлена в августе 2016 года. А ещё там есть наклеечка, утверждающая, что плата на самом деле ATI Radeon 9550.

Чувствуется фамильное сходство, не так ли?

При подключении двух мониторов плата предварительно инициализирует тот, который подключен к VGA, но в дальнейшем считает основным подключенный к DVI.

Драйвера устанавливаются нормально, карта появляется в диспетчере устройств, после чего можно использовать расширение рабочего стола.

Параметры через GPU-Z вычитываются.

Пару рабочих столов в разрешении 1600х1200 при 32-битной глубине цвета видеокарта тянет.

По производительности плата 2003 года разработки примерно на уровне MX400, поэтому запускать на ней современные бенчмарки смысла нет — сейчас это просто два дополнительных видеовыхода в ПК.

Вывод: при цене чуть менее 17$ на момент покупки видеокарта вполне может заменить два конвертера USB2.0-VGA или USB2.0-DVI общей стоимостью 80-90$. Так что если нужно добавить пару видеовыходов, а PCI-E в дефиците, но есть свободные PCI — это неплохой вариант решения проблемы.

Самые обсуждаемые обзоры

| +224 |

3775

137

|

| +23 |

1010

43

|

Нет, что-бы сказать просто: берите любую видуху и пихайте в PCI — все. Финита ля комедия.

А то многие PCI-карты, бывает, не успевают отрисовывать картинку, особенно в относительно больших разрешениях. Как раз что-то уровня geforce mx200 плюс-минус.

Вот у меня 550ti кажется сейчас в рабочем. В рабочем состоянии легко найти за 1000 рублей. Быдет 1 гиг оперативы. Вроде как есть и 2 гиговые. Легко тянет вот это (3 моник не переключен на вход на этот комп, но я им и так не сильно часто пользуюсь):

Бу мамка с PCI-E и какой-нибудь pentium 3440 в купе с нормальной ddr3 а не некрофилийной ddr2 (и уже легко 8 гигов, если поднатужится и найти мамку с 4 ddr слотами, то и все 16) выйдет в 5-ку. И по современным меркам вполне себе легко и не принужденно смотреть любой контент в fullhd и при этом делать еще много что.

Просто у меня достаточно много компьютеров уровня c2d (всякие там E1200, E1400 и т.п.), где хотят ещё мониторов. Ставил туда старенькие PCI — mx200, riva128, rendition verite и т.п. — но тормоза даже в прорисовке окон наблюдаются. Любое видео на этих видеокартах в слайдшоу превращалось.

Не знаю как на счет старья, но на современных (точно делал такое на Z77 чипсете) можно включить первой встроенную графичку и тогда в системе останется встроенная графичка и по дефолту основным монитором в том числе биос будут лезть туда. Остальные будут так же работать. В старье может и не быть такого. Но я лчше буду смотреть в 2 монитора и лишний раз переключать, чем ловить фризы на чем-то сложнее косынки из win xp.

А затычка на pci-e даст только два монитора и вырубит встроенное видео.

Так что третий-четвертый монитор надо совать в свободные слоты. Если есть ещё pci-e — хорошо. Если же нет, то приходится шаманить с PCI или USB.

Блин. только сейчас залез, у меня основной моник подключен к встройке… оказывается реально засада. Или 2-х чиповые видяшки или специалные какие-то 290-е.

А вообще максимум я шесть мониторов цеплял, правда это было во времена 98. Двухголовый матрокс и несколько s3. В реальной же жизни 95% хватает двух мониторов, третий и выше появляются редко. Но вот у меня в хозяйстве таких систем штук пять. Видеонаблюдение плюс один дизайнер.

стоит использовать только если у вас бесплатное электричество, 35 ватт это очень оптимистичное заявление. Ну и дискам IDE не долго осталось работать, в любой момент могут отказать.

А так, да, электроэнергию потребляет, ради торрента есть смысл например мобильную версию старого проца поискать если уж совсем ретро хочется. Ну или эмулятор того же ретро компа использовать.

Впрочем есть особые мазохисты, страдающие ностальгией. На днях поеду комп забирать ACER MPF-PC/710. Мой первый комп, на котором я начал учиться (параллельно с домашними бытовыми).

Я например тоже использую карточку из топика… первую (практически 1 в 1), S3 Trio64v+ помоему называется. Процессор у меня AMD 8320e + еще 2 видеокарты R7 240 и RX 480. В ближайшее время буду абгрейдиться на Рязань или новый 6/12 Штеуд. И нисколько не сомневаюсь, что как минимум постараюсь воспользоваться своей S3 Trio64v+, если получится, потому что она нужна.

-И для чего?

Очень просто: виртуализация.

С выходом Win10, лично мне, стало стремно от мысли, что когда-то придется переходить на «это» на десктопе, или может быть на еще что-то более мерзкое. (не хочу развивать срач, каждому своё) Собственно по этой причине окончательно вкатился в Linux. Но желание играть в еба игры никуда не делось. Отсюда и следует потребность в виртуализации. Соотвественно:

Слабая карточка PCI — хосту, просто отрисовывать букововки консоли.

Средняя карточка — десктопу, куда то же надо втыкать мониторы и нужно минимальное видео ускорение.

Мощная карточка — «прошивке для игор». И пусчай там в этой прошивке (отдельной на каждую игру): выскакивает реклама в «пуск», происходит автозапуск ненужных служб и всплывающих окон. Пущай она хоть всю информацию своего жеского диска сливает куда хочет. Не надо никаких антивирусов (в 2017 обладающих основными свойствами вирусов) и обновлений. Даже состояние системы хранить необязательно: закончил с приложением и вернул систему к моменту первой установки, без багов и тормозов и вечным триалом (вот последнее пока не автоматизировал).

Как представлю, что придется вернуться в такой виндо мирок… бррр… дрожь берет. К хорошему быстро привыкаешь.

А что-то подробнее… не знаю, что вы хотите узнать?

Проблематика следующая: Windows 10 занимается на ПК пользователя множеством разных непотребств, больша́я часть ПО из Windows мира грешит тем же. Сидеть на системе Windows 10 и в окружении ПО, которое занимается непотребствами — стремно (помоему).

Решение: разделить системы/приложения занимающиеся непотребствами на изолированные зоны.

Пусчай они занимаются этим сами с собой, я участвовать в этом своими данными, поведением, метриками и прочей бигдатой не хочу. Другого метода решения, кроме как виртуализация, я не нашел. Можно было бы поискать в самой Windows или в виде стороннего приложении способ реализации ACL на подобии Selinux, Apparmor и настроить границы зон непотребств самостоятельно. Но это видится мне не реализуемым.

Во первых надо доверять самой системе или реализующему этот функционал приложению (что крайне спорно).

Во вторых настройка какой фильтрации будет в сотни раз сложнее, нежели просто запускать каждое Windows приложение в отдельной виртуалке.

Существует технология IOMMU (Штеуд VT-d или AMD-Vi), которая позволяет пробросить PCI устройство в виртуальную машину, причем полностью аппаратным способом, без потери производительности. Что/куда пробраcывать настраивается на уровне гипервизора.

С тех пор много поколений всего сменилось и очень удивительно мне, что именно отсутствие второй видяхи ограничивает потребительские свойства компа?

1) Дополнительная видеокарта и основная обязательно должны быть от разных производителей чипсетов (ATI-NVIDIA-SIS-3dfx): GF2MX400 и GTX650 в одном системном блоке не уживутся, банально нет драйвера, поддерживающего обе видеокарты.

2) Если при перемещении окошек на дисплее появляется шум в наушниках- помогает изменение PCI Latency в биосе материнки.

GA-8VT880P например

ТТХ нагуглил www.cnet.com/products/ati-firemv-2200-pci-64mb/specs/

Если она, то:

Кабель такой в нерезиновой продают за 600 руб, на али за $4.5-7.5 в зависмости от конфигурации (2DVI, 2VGA, DVI+VGA) и жадности

Пример https://aliexpress.com/item/item/IMC-Hot-DMS-59-Male-to-2-Dual-Link-DVI-I-24-5-Pin-Splitter-Adapter/32639235700.html

У драйверов этой карты есть по крайней мере под Windows 7 забавный глюк.

Выглядит он следующим образом.

К системному блоку с ATI FireMV 2200 и GeForce 6100 подключены 3 монитора с разрешением 1600х1200.

После загрузки всё работает нормально до того момента, как видеокарты не уйдут в спячку по неактивности пользователя.

После возобновления работы разрешение монитора, подключенного к ATI FireMV 2200, скукоживается с 1600х1200 до 1024х768, и вернуть его обратно через меню настроек невозможно.

Ситуация исправляется только перезагрузкой и только до того момента, как видеокарты снова залягут в режим энергосбережения.

При только двух мониторах, подключенных к ATI FireMV 2200, таких проблем нет.

Кстати, есть и вариант подключить как дополнительный монитор iPad. Наверняка и для андроида есть.