Обзор адаптера для подключения двух M2 NVMe SSD к одному PCI-E порту (поддержка PCI-E Gen3)

- Цена: 906р

- Перейти в магазин

Всем привет. Сегодня я расскажу об адаптере, позволяющем подключить сразу два M2 NVMe SSD к одному PCI-E порту. Такое может понадобиться, например, если нужно создать программный RAID-массив из двух накопителей (средствами ОС), а слот М2 на материнской плате всего один, но есть свободные PCI-E слоты.

Для корректной работы адаптера требуется поддержка PCI-E Bifurcation со стороны BIOS материнской платы (возможность настройки этого параметра встречается не сильно часто).

Обычно, когда нужно подключить M2 NVMe SSD через PCI-E слот, используется вот такой вот пассивный адаптер с разводкой x4:

Его можно использовать как на древнем компьютере где вообще нет М2 слотов, так и на современном, если одного или двух (бывает не всегда) М2 слотов не достаточно для задач пользователя. Бывают ещё и варианты таких адаптеров, физически выполненные с коннектором x1.

Его можно использовать как на древнем компьютере где вообще нет М2 слотов, так и на современном, если одного или двух (бывает не всегда) М2 слотов не достаточно для задач пользователя. Бывают ещё и варианты таких адаптеров, физически выполненные с коннектором x1.

В моём случае, так же можно было использовать такой вариант, когда один SSD работает в М2 NVMe слоту, и второй в таком вот простеньком адаптере, а саму ОС грузить с SATA SSD.

Но вариант использования именно активного адаптера на два SSD сразу, мне видится более интересным, так как его стоимость относительно небольшая (примерно в 2.5- 3 раза дороже пассивного на один SSD), и у меня остаётся возможность задействовать оставшийся свободным М2 NVMe слот при необходимости, а так же, у адаптера есть бонус в виде DC-DC понижаек с 12В (забегаю вперёд), по питанию каждого из SSD, что пригодится мне если я таки смогу реализовать что то вроде самодельного бесперебойника, с основным выходом на 12В, но это уже другая история.

Кроме того, если блок питания используется сомнительного качества, то SSD будут получать более стабильное питание, чем если бы они напрямую сидели на 3.3В от БП.

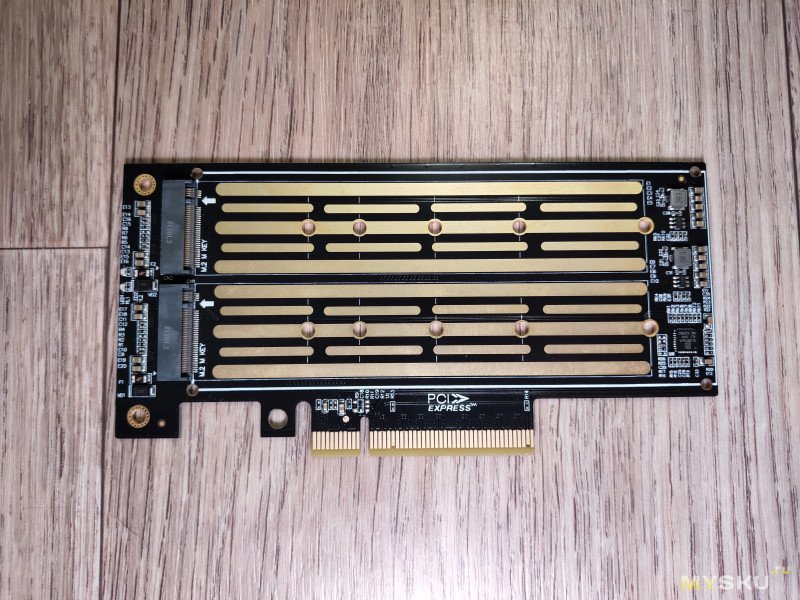

Распаковка и обзор аппаратной начинки адаптера, для понимания его возможностей.

Приехал адаптер в обычной коробочке, но в данном случае чем дешевле упаковка тем лучше, при условии что она надёжно защищает адаптер при транспортировке.

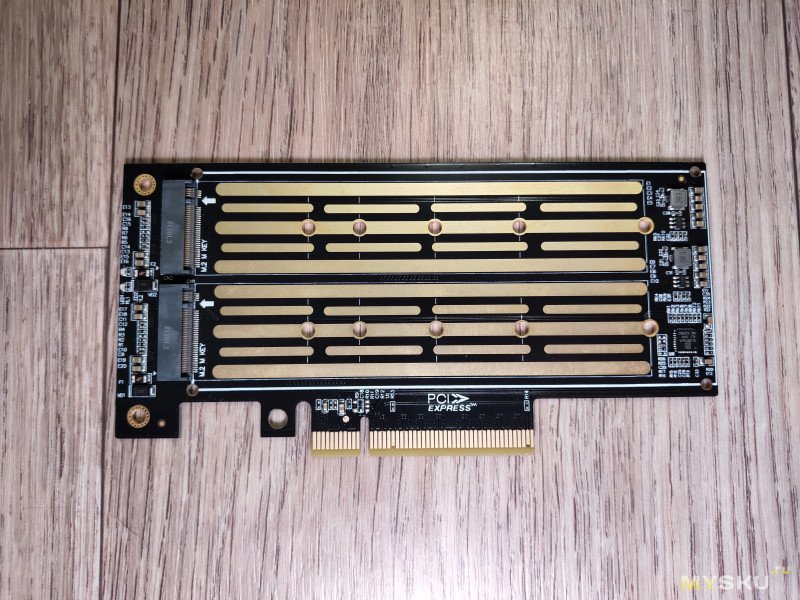

Внутри коробки находится сам адаптер, 4 винта и две гайки для крепления SSD, два винта для крепления планок, отвёртка, две планки (полноразмерной высоты и укороченная).

Внутри коробки находится сам адаптер, 4 винта и две гайки для крепления SSD, два винта для крепления планок, отвёртка, две планки (полноразмерной высоты и укороченная).

Адаптер имеет интерфейс PCI-E x8.

Адаптер имеет интерфейс PCI-E x8.

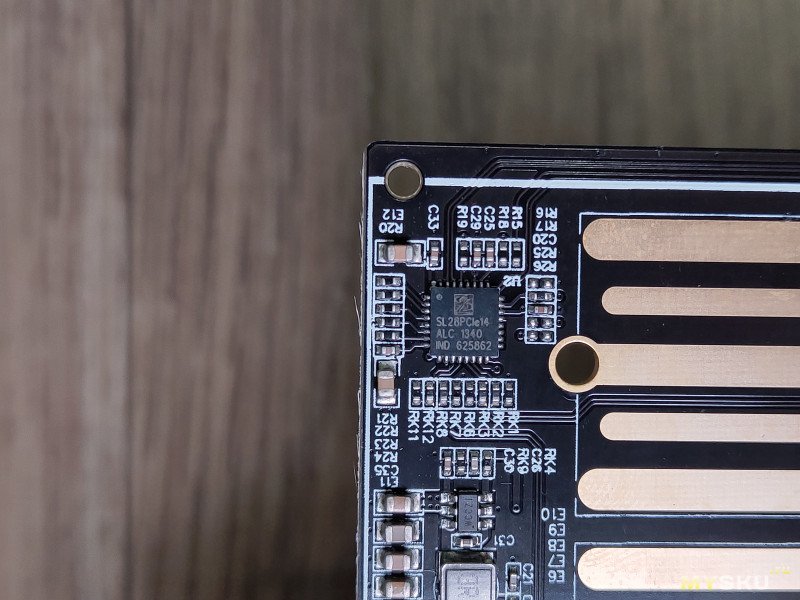

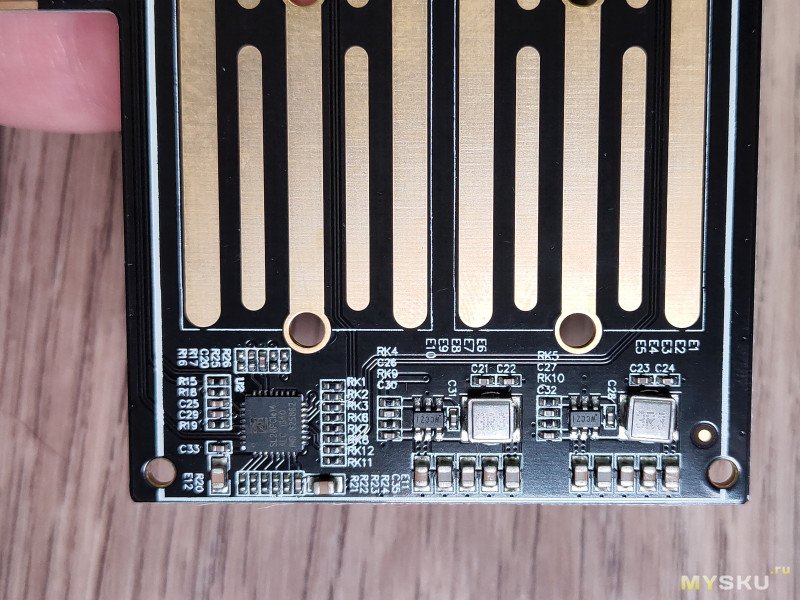

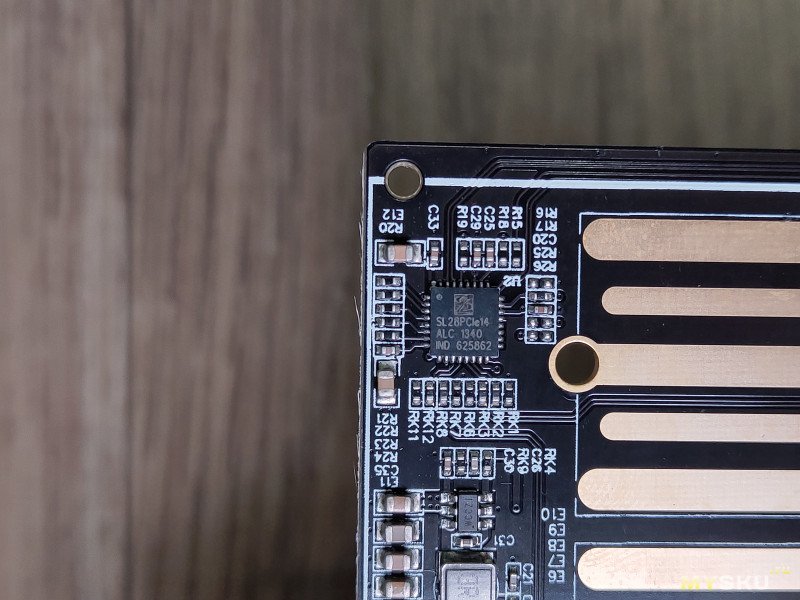

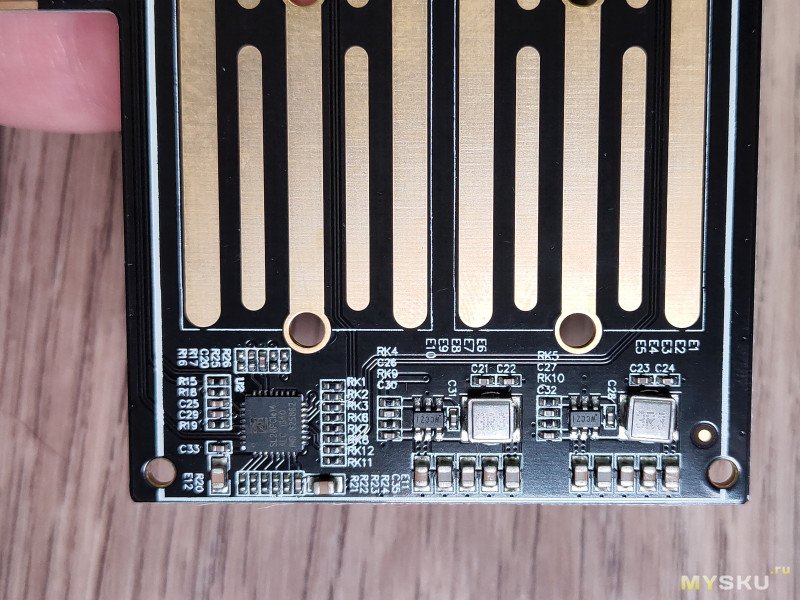

Контроллер адаптера и DC-DC преобразователи с 12В в 3.3В:

Контроллер адаптера и DC-DC преобразователи с 12В в 3.3В:

Адаптер построен на контроллере SL28PCIE14. В описании к нему сказано что это «PCI-Express Gen 2 & Gen 3 Clock Generator & Fan-out Buffer with EProClock ® Technology». Насколько я понимаю, контроллер содержит 4 тактовых генератора, максимально рассчитанных на работу шины в режиме PCI-E Gen3, и используется данный контроллер видимо для синхронной работы нескольких устройств в рамках одного порта.

Адаптер построен на контроллере SL28PCIE14. В описании к нему сказано что это «PCI-Express Gen 2 & Gen 3 Clock Generator & Fan-out Buffer with EProClock ® Technology». Насколько я понимаю, контроллер содержит 4 тактовых генератора, максимально рассчитанных на работу шины в режиме PCI-E Gen3, и используется данный контроллер видимо для синхронной работы нескольких устройств в рамках одного порта.

Т.е даже если вставить этот адаптер в PCI-E Gen4 слот, работать он всё равно будет в режиме Gen3. С PCI-E Gen1 он возможно вообще не заработает (не проверял).

Что касается контроллеров DC-DC преобразователей, я не смог найти информацию о них по маркировке WCCZI.

Как настроить компьютер под корректную работу адаптера?

Предыстория покупки такова, что у меня есть компьютер, построенный на материнской плате JGINYUE TITANIUM D3, которая умеет PCI-E Bifurcation, так как BIOS там сдёрнут с серверной двухсокетной платы. На базе этой платы я планирую строить быструю онлайн хранилку, с использованием ZFS кэширования второго уровня, на NVMe SSD, и ещё кое что интересное.

На плате всего один слот под NVMe SSD, а мне хочется установить именно два таких накопителя. Данная материнская плата имеет хорошее количество PCI-E слотов, способных обеспечить нужные скорости как для двух NVMe SSD, так и для PCI-E Ethernet карты на 10Гбит/c, RAID контроллера (под работу с SAS HDD), так и для видеокарты (так как в процессорах E5 нет встроенной графики, видюха нужна чисто для показа картинки и не более).

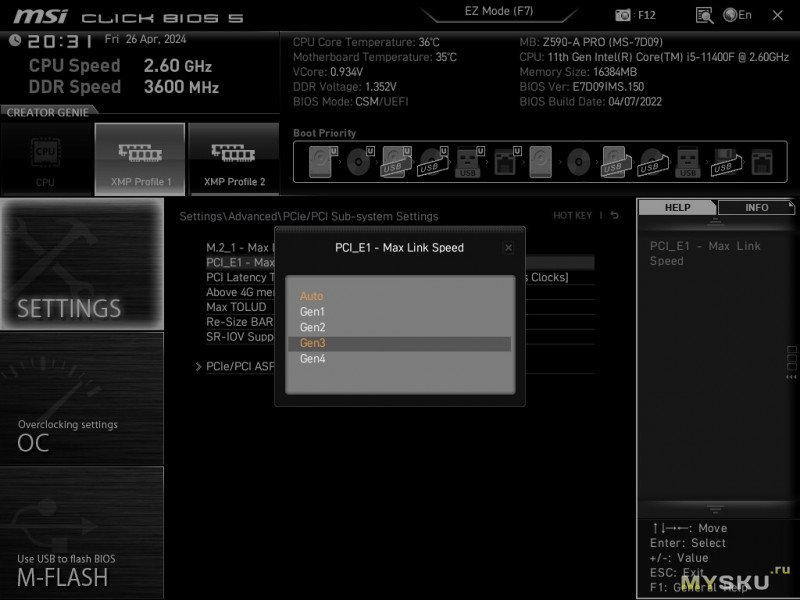

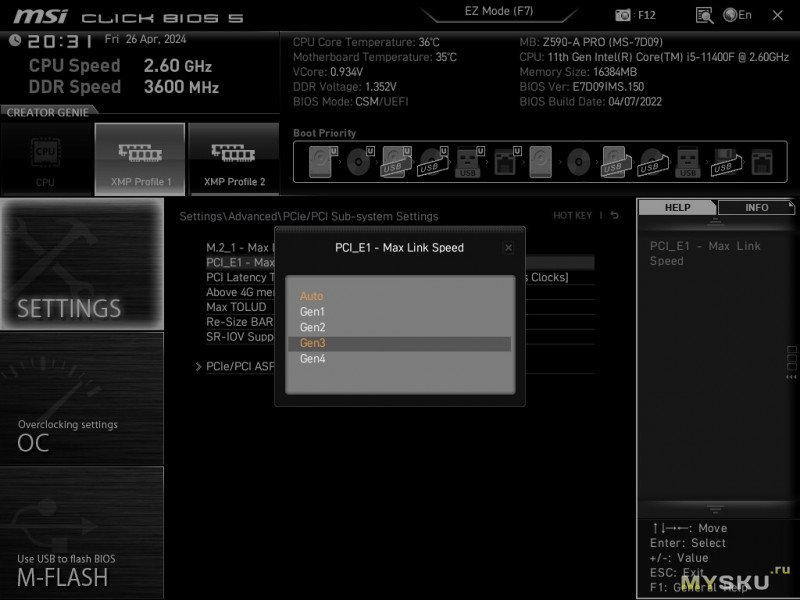

Есть у меня и более современный компьютер на базе MSI Z590-A PRO, который я конечно же не планировал использовать под хранилку, но было любопытно поддерживается ли там PCI-E Bifurcation. Ответ — нет. В BIOS нет таких опций, несмотря на то что плата весьма функциональна, и по сути относится к околотоповому сегменту если мы говорим о материнских платах на чипсете Z590.

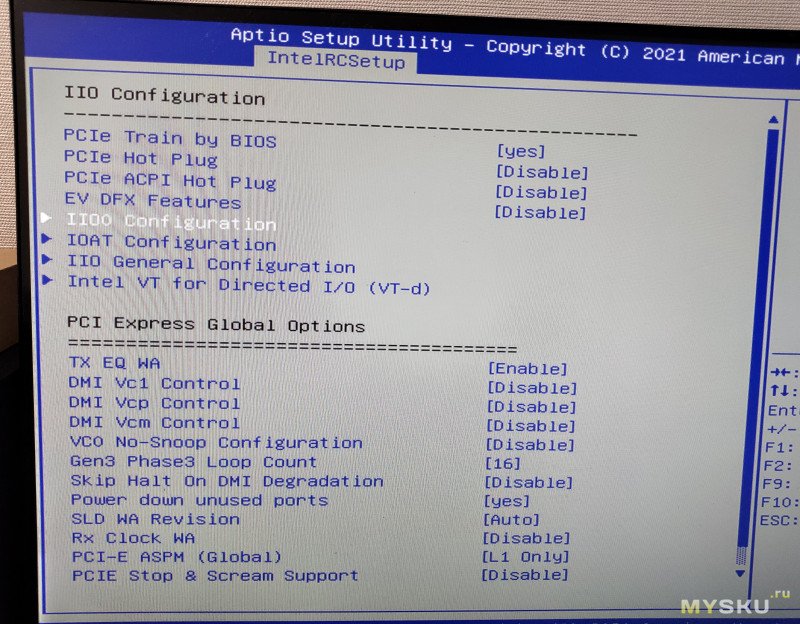

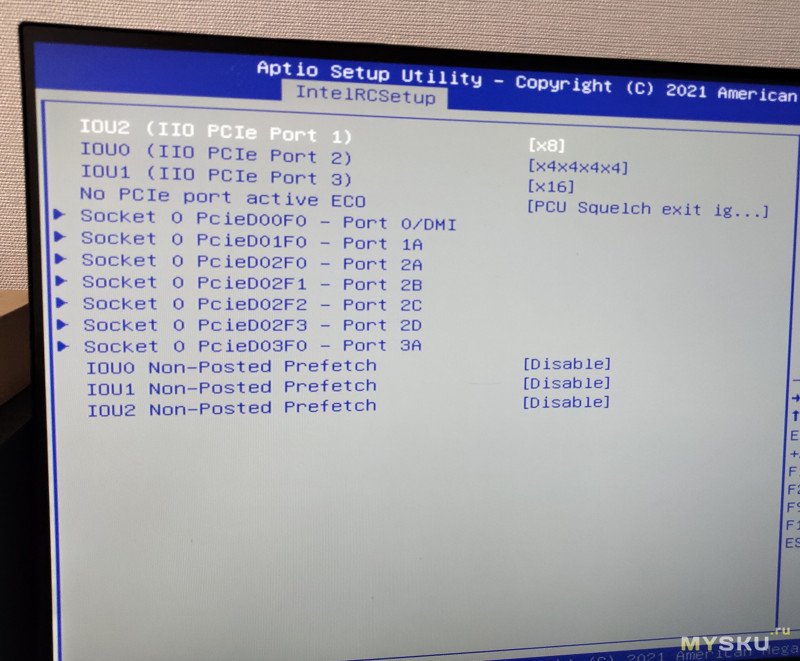

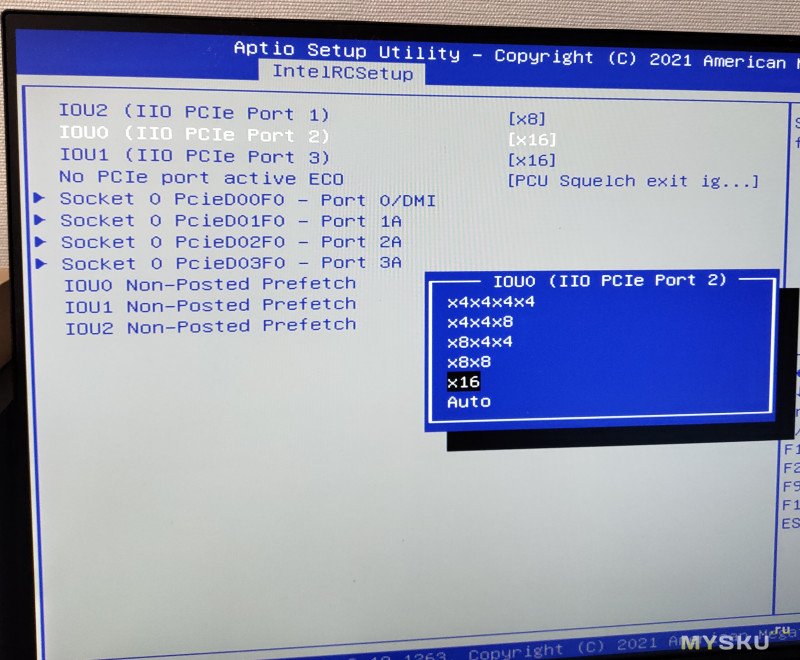

Вот скриншоты доступных в BIOS настроек:

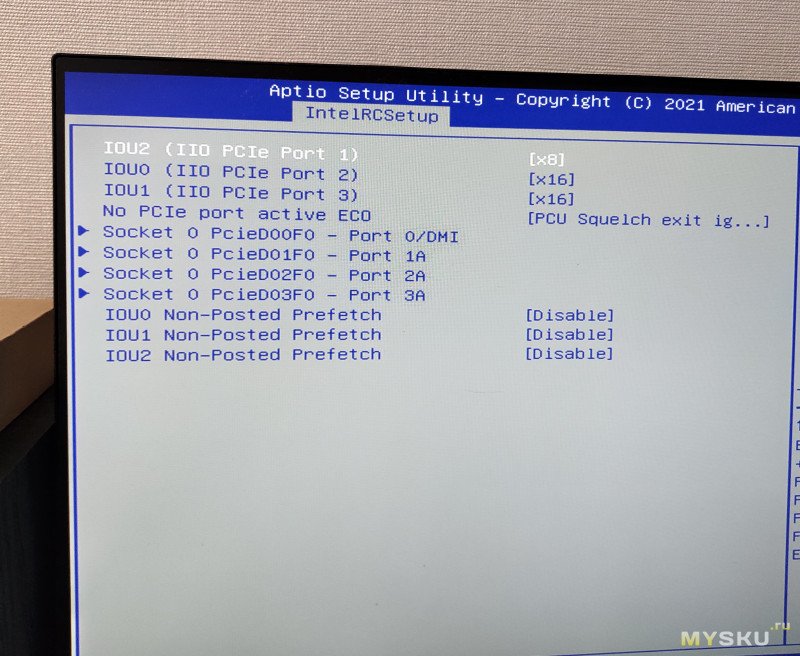

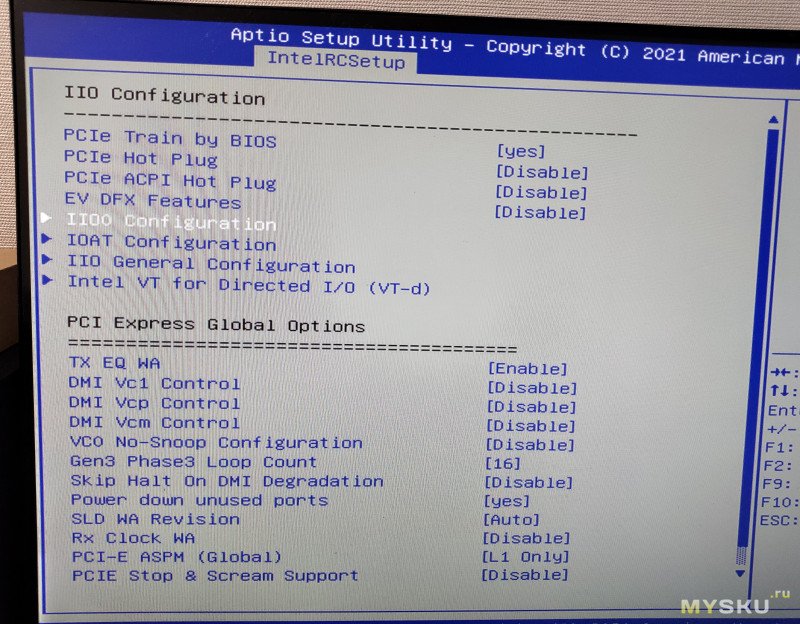

В BIOS платы JGINYUE TITANIUM D3 настройка PCI-E Bifurcation находится здесь:

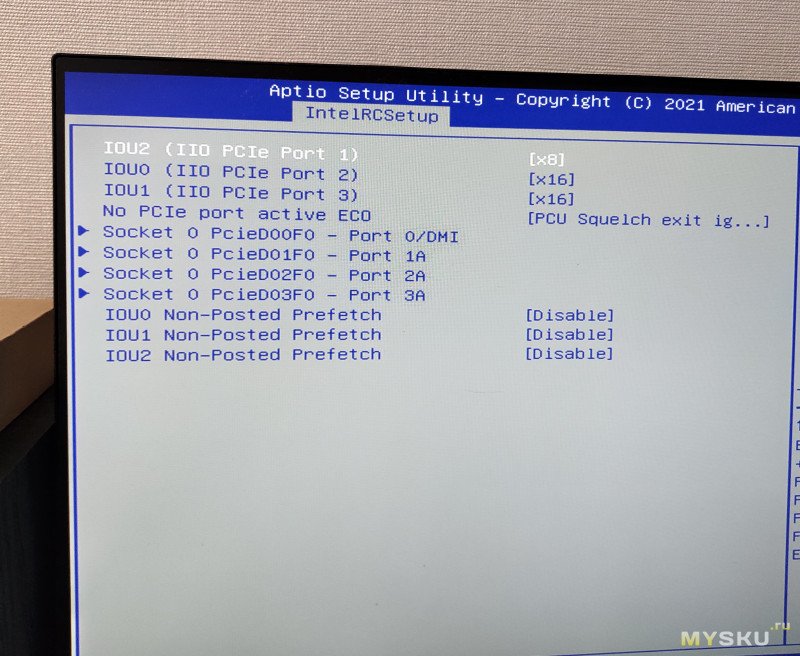

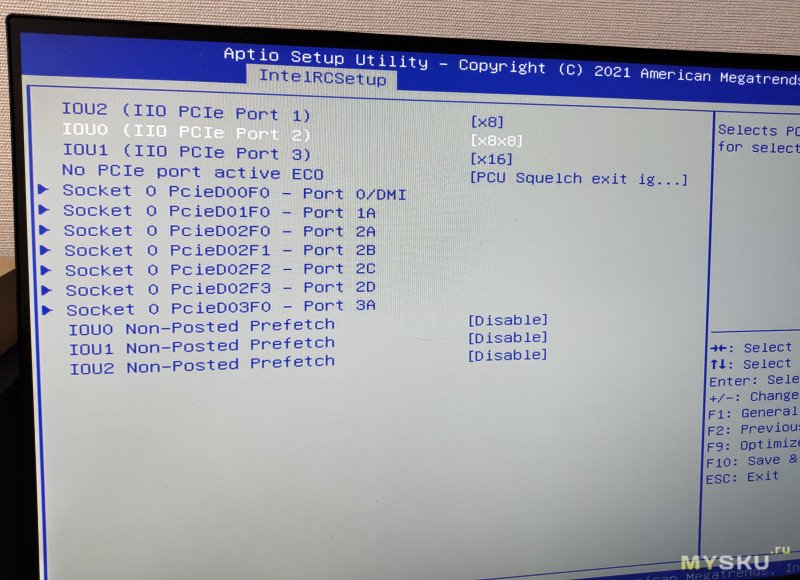

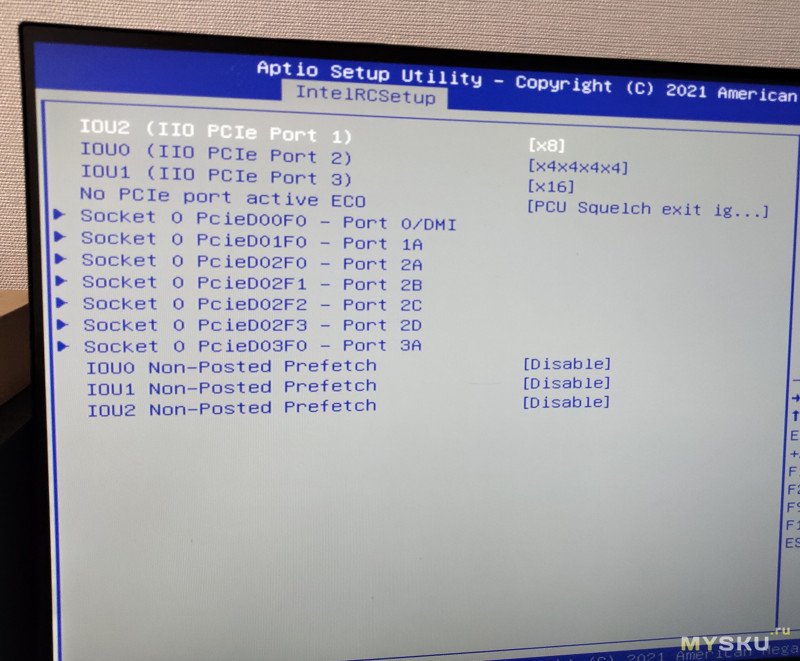

Настройки конфигурации портов по умолчанию:

Настройки конфигурации портов по умолчанию:

Адаптер рассчитан для подключения в PCI-E слот x8, что логично, так как разведено там 2*4 линии PCI-E.

Адаптер рассчитан для подключения в PCI-E слот x8, что логично, так как разведено там 2*4 линии PCI-E.

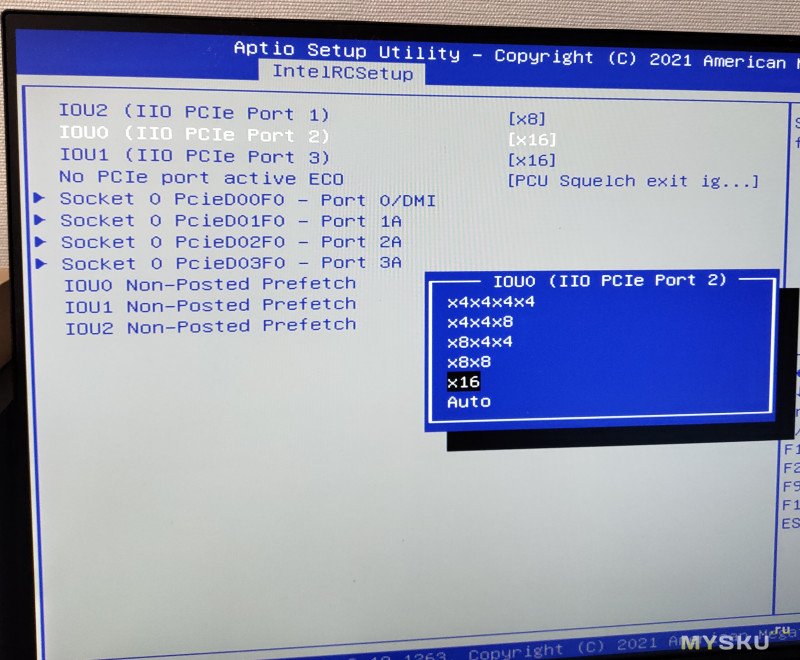

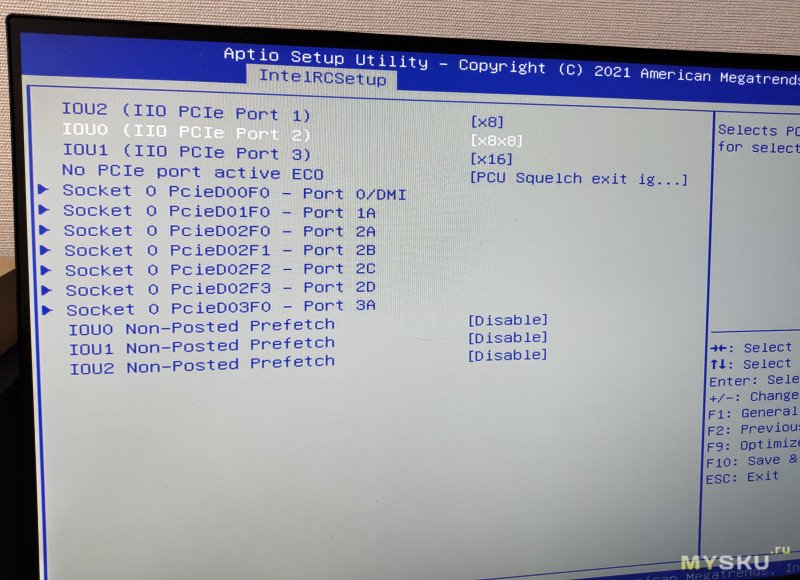

Устанавливать адаптер я буду в верхний PCI-E слот (x16), материнской платы. В BIOS он обозначается как Port2, его и будем настраивать.

Если выбрать вариант разделения линий внутри слота на пару устройств, по x8 каждая, то адаптер не будет работать корректно. ОС в таком случае увидит лишь один накопитель из двух. Тоже самое будет если вообще ничего не конфигурировать, оставив лишь 16 линий, чисто под одно PCI-E устройство, или установить адаптер в ту же MSI Z590-A PRO.

Если выбрать вариант разделения линий внутри слота на пару устройств, по x8 каждая, то адаптер не будет работать корректно. ОС в таком случае увидит лишь один накопитель из двух. Тоже самое будет если вообще ничего не конфигурировать, оставив лишь 16 линий, чисто под одно PCI-E устройство, или установить адаптер в ту же MSI Z590-A PRO.

Для корректной работы адаптера, нужно выставить вариант x4x4x4x4, т.е. разделяя 16 линий на 4 устройства, отдавая по 4 линии на каждое устройство.

Для корректной работы адаптера, нужно выставить вариант x4x4x4x4, т.е. разделяя 16 линий на 4 устройства, отдавая по 4 линии на каждое устройство.

Тесты

Для тестов я взял два NVMe SSD на 1ТБ. В данном случае это Team Group A440 и Team Group MP44 (скоро напишу про них полноценные обзоры).

Не смотря на то что это разные модели, их начинка на 100% одинаковая, даже на их платах написан один и тот же номер.

Не смотря на то что это разные модели, их начинка на 100% одинаковая, даже на их платах написан один и тот же номер.

На вышепоказанном фото, можно видеть что винты вкручены кривовато, так как только в таком положении удалось закрепить накопители, и то не с первого раза, из-за того что продавец положил в комплект слишком короткие винты для крепления SSD.

На вышепоказанном фото, можно видеть что винты вкручены кривовато, так как только в таком положении удалось закрепить накопители, и то не с первого раза, из-за того что продавец положил в комплект слишком короткие винты для крепления SSD.

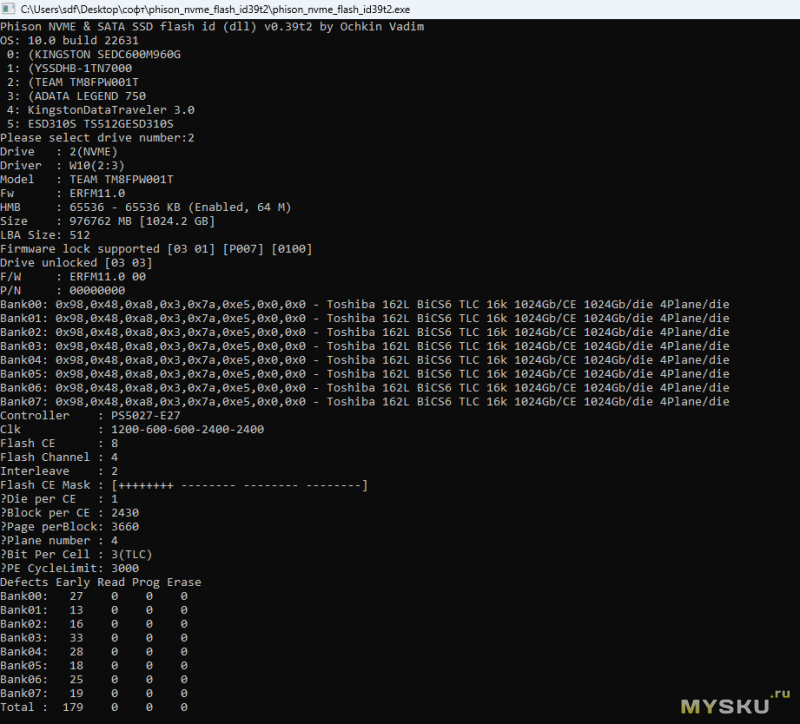

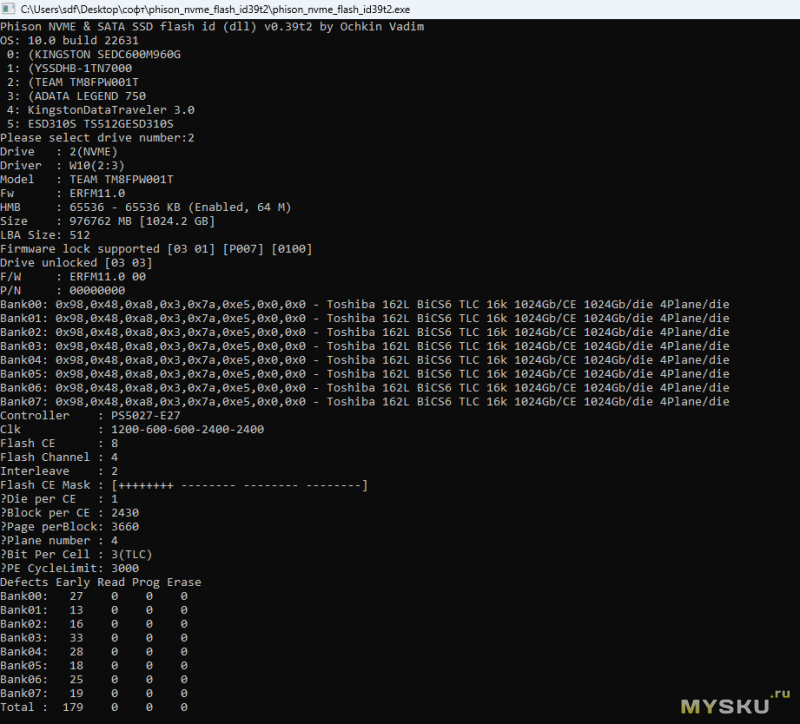

Данные из программы от Вадима Очкина (vlo) по начинке MP44:

Кстати, касаемо программного RAID 1 (зеркало), покрайней мере реализованного средствами Windows 10, то он не гарантирует достоверность данных, он лишь защищает от их потери. Другими словами, данные он отдаст в случае краха одного из накопителей, но вот будут ли это именно те данные что записывались, гарантии нет. Конечно, вероятность такой ситуации что будут отданы искажённые данные крайне мала, но она есть.

Некоторое время назад я проводил эксперемент на виртуалке, изменяя значения данных через WinHex на одном из накопителей, входящих в массив, тем самым эмулируя ситуацию что на двух накопителях находятся разные данные. ОС, (с ФС NTFS), никак это не проверяет, так как такой задачи изначально видимо не ставилось, и сами данные не проверяются на достоверность. Та же ФС ZFS может чекать корректность хранимых данных по запросу.

Ну и собственно пора начать тестирование. Тестировать я буду в программе CDM.

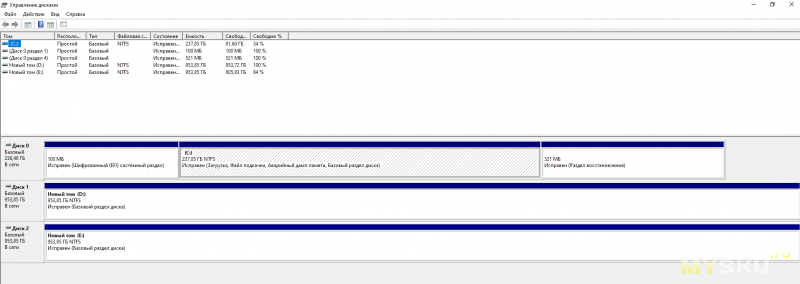

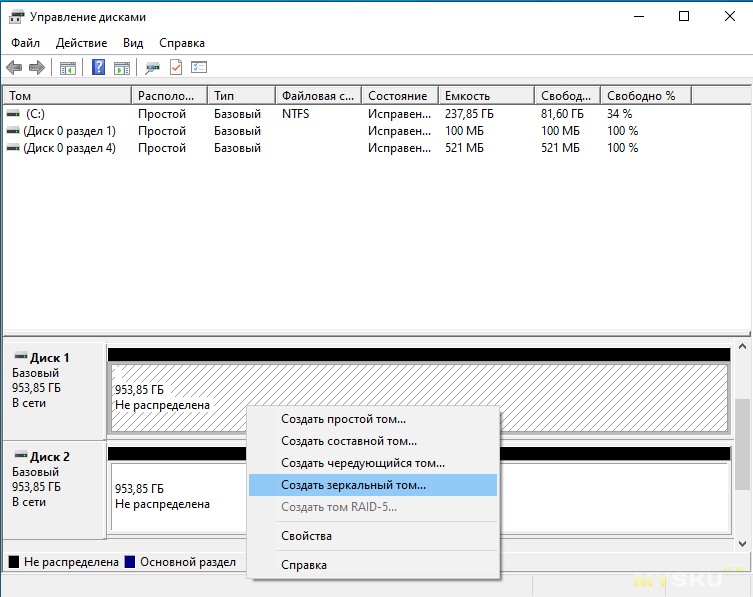

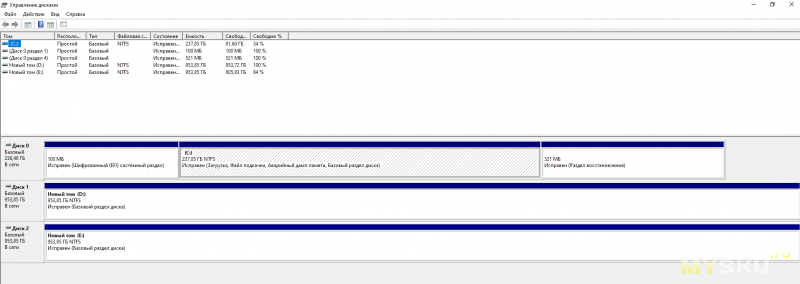

Для начала, убедимся что в диспетчере дисков видны оба накопителя:

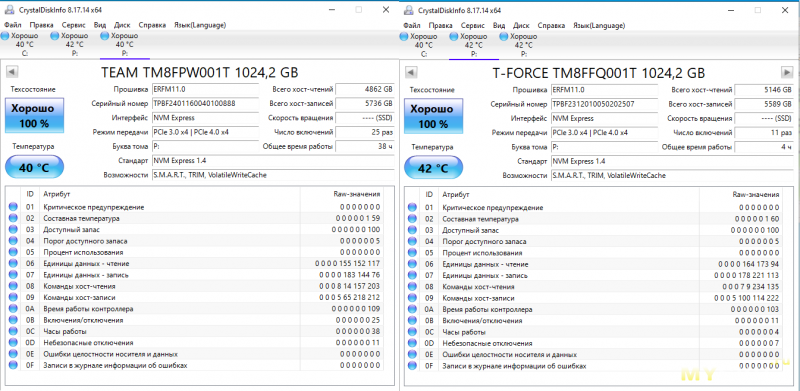

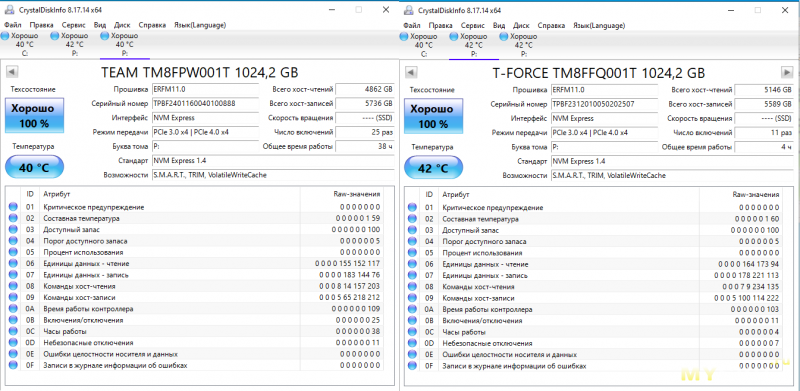

В CDI оба SSD определяются корректно (на момент создания скринов, они уже находились в составном накопителе, поэтому у обоих SSD одна и та же буква):

В CDI оба SSD определяются корректно (на момент создания скринов, они уже находились в составном накопителе, поэтому у обоих SSD одна и та же буква):

Как видим, Gen4 SSD здесь работают в режиме Gen3 (и материнская плата и активный адаптер поддерживают только Gen3 режим PCI-E).

Как видим, Gen4 SSD здесь работают в режиме Gen3 (и материнская плата и активный адаптер поддерживают только Gen3 режим PCI-E).

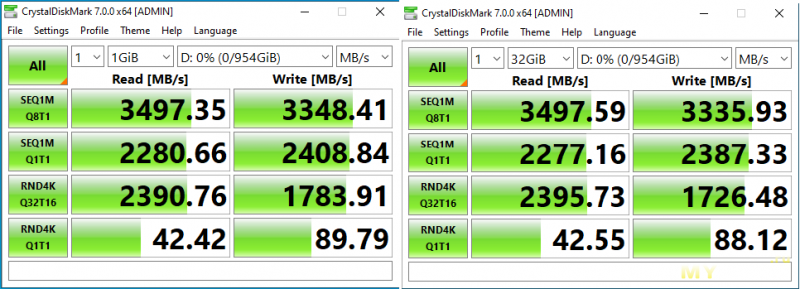

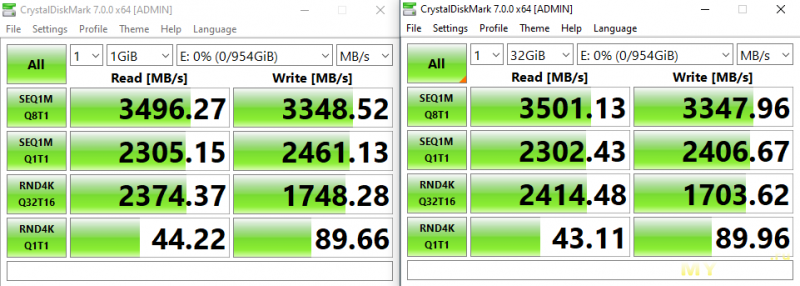

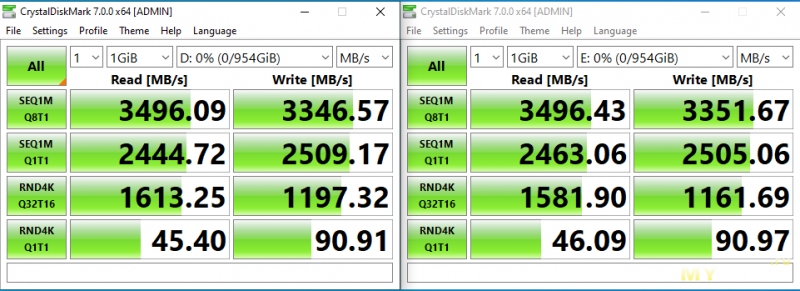

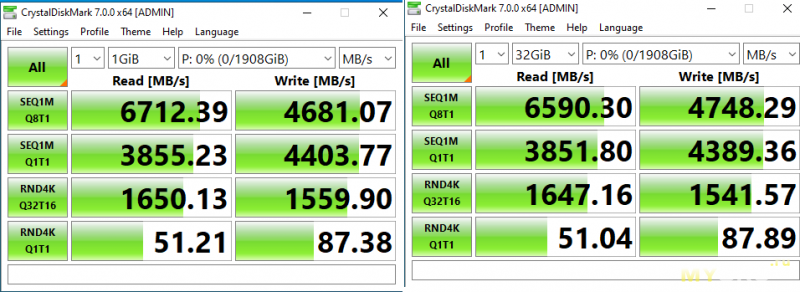

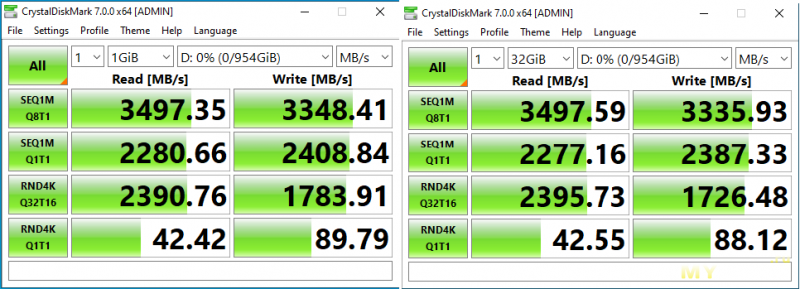

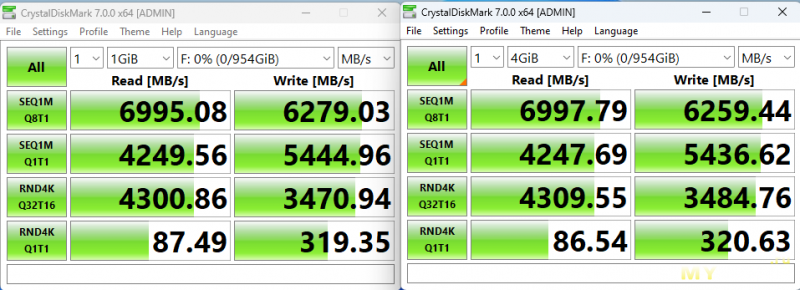

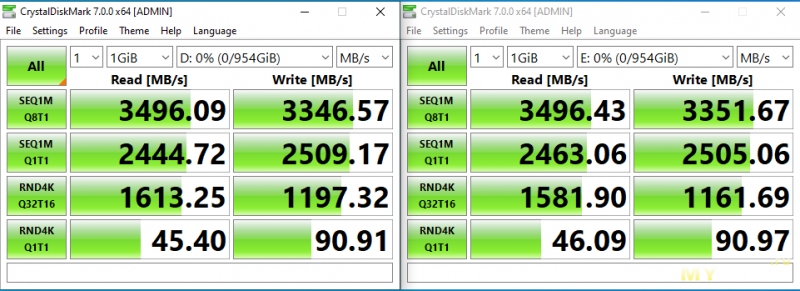

Проверю скорости в CDM, при работе только одного SSD (второй стоит без нагрузки):

Получившиеся скорости соответствуют потолку возможностей PCI-E Gen3 x4. Такие же скорости наблюдались бы по данному SSD будь он установлен через пассивный x4 переходник, в этот же PCI-E слот материнской платы. Вот такие скорости обеспечивает SSD при работе через пассивный переходник, т.е прямом подключении к PCI-E контроллеру процессора:

Сам SSD может работать существенно быстрее, если дать ему PCI-E Gen4 x4 шину.

Сам SSD может работать существенно быстрее, если дать ему PCI-E Gen4 x4 шину.

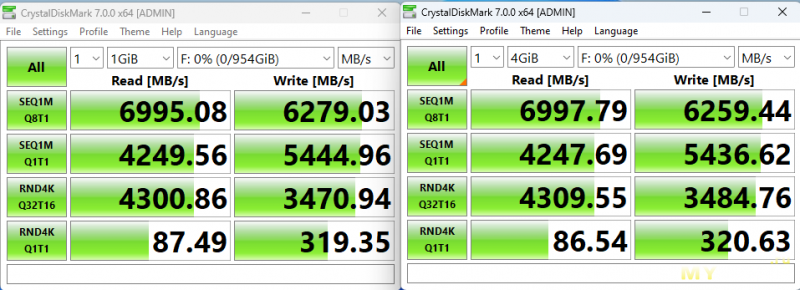

Скриншот тестов в MSI Z590-A PRO (SSD работает в режиме PCI-E Gen4 x4):

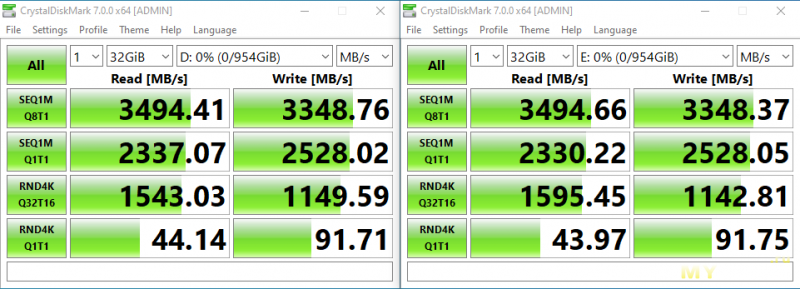

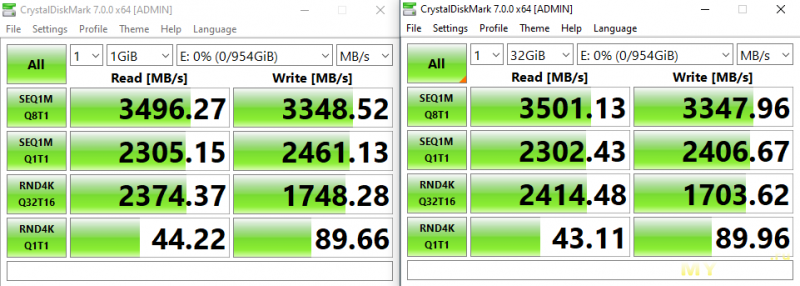

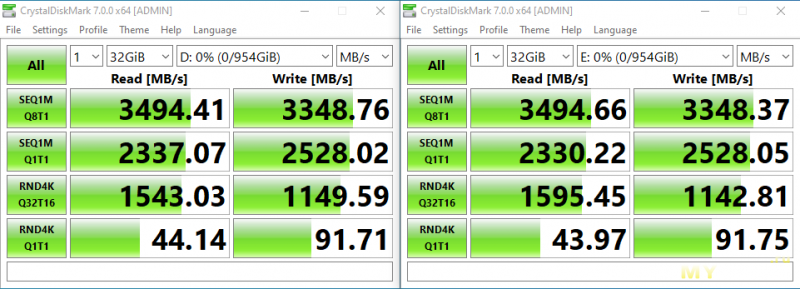

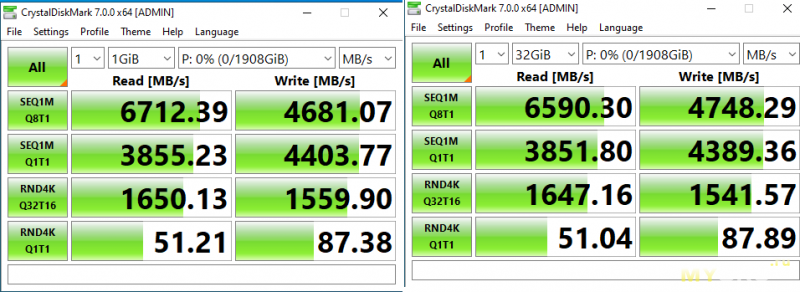

Теперь запущу одновременный тест в CDM (почти одновременно жму кнопку запуска теста по обоим SSD):

Видно, что скорости получились одинаковыми (разница на уровне погрешности), при этом скорости не режутся между накопителями, так как на каждый идёт по 4 выделенных линии PCI-E Gen3. Скорости при одновременной работе двух SSD, аналогичны скоростям когда работал только один SSD из двух, если мы говорим про линейное чтение/запись большими блоками. Случайное многопоточное чтение с очередью (Q32T16) несколько просело (задержки увеличились), но это не так критично.

Видно, что скорости получились одинаковыми (разница на уровне погрешности), при этом скорости не режутся между накопителями, так как на каждый идёт по 4 выделенных линии PCI-E Gen3. Скорости при одновременной работе двух SSD, аналогичны скоростям когда работал только один SSD из двух, если мы говорим про линейное чтение/запись большими блоками. Случайное многопоточное чтение с очередью (Q32T16) несколько просело (задержки увеличились), но это не так критично.

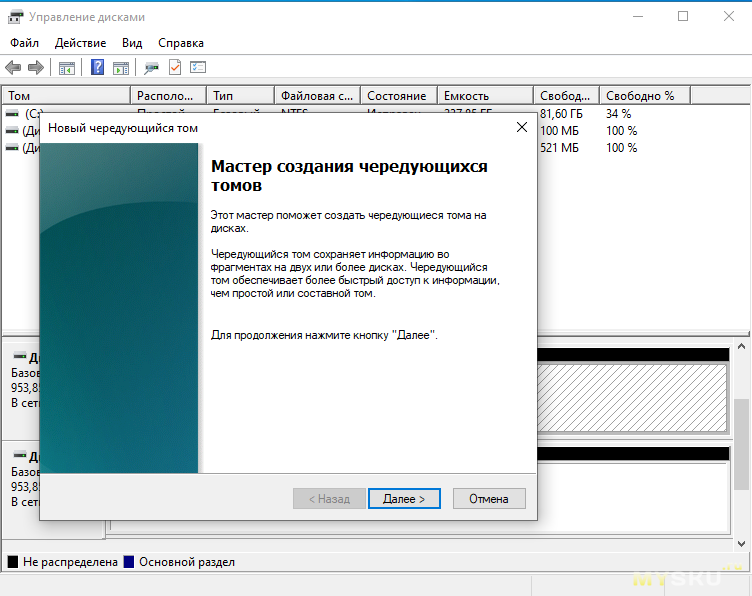

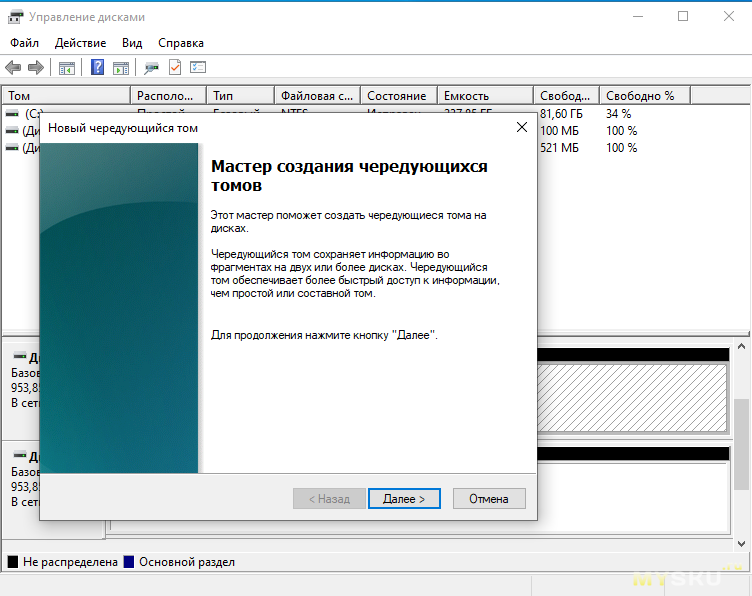

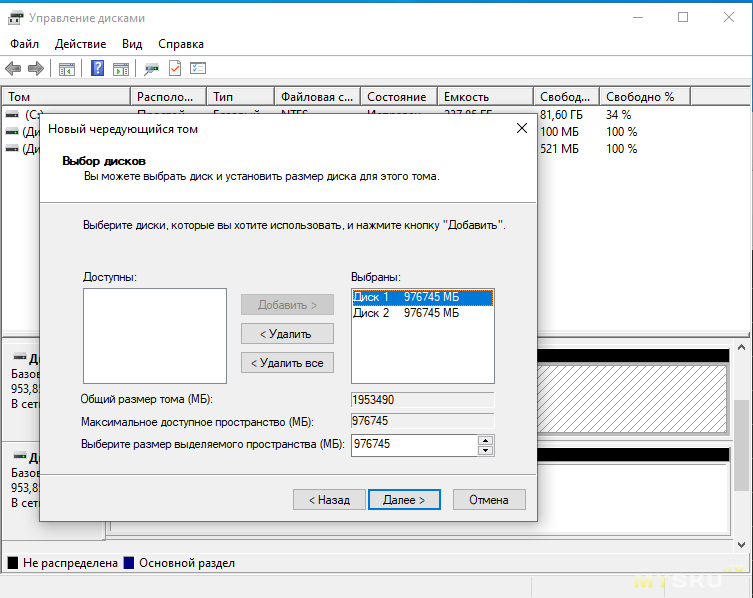

Теперь создам ради интереса чередующийся том:

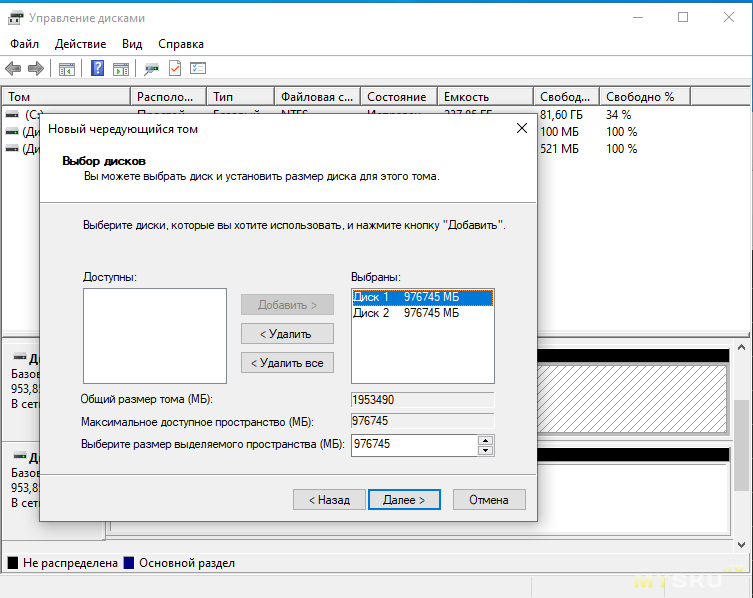

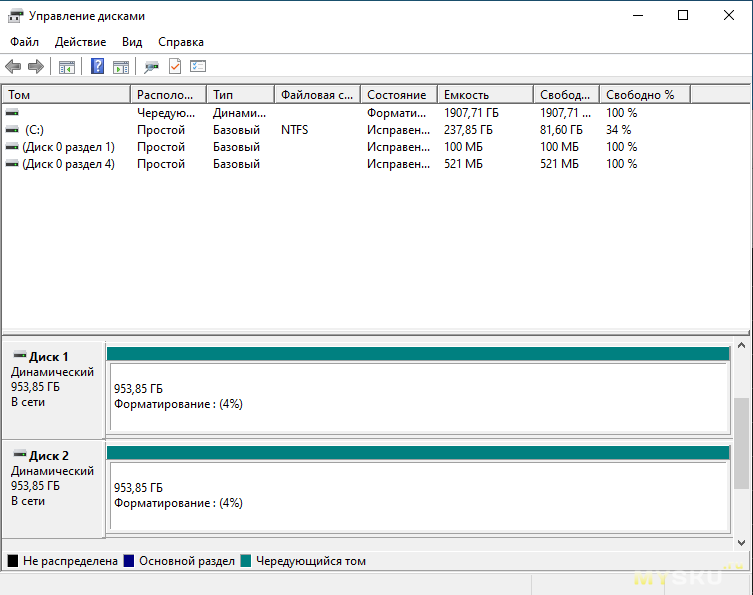

Начинается форматирование дисков, тратящее ресурс SSD:

Начинается форматирование дисков, тратящее ресурс SSD:

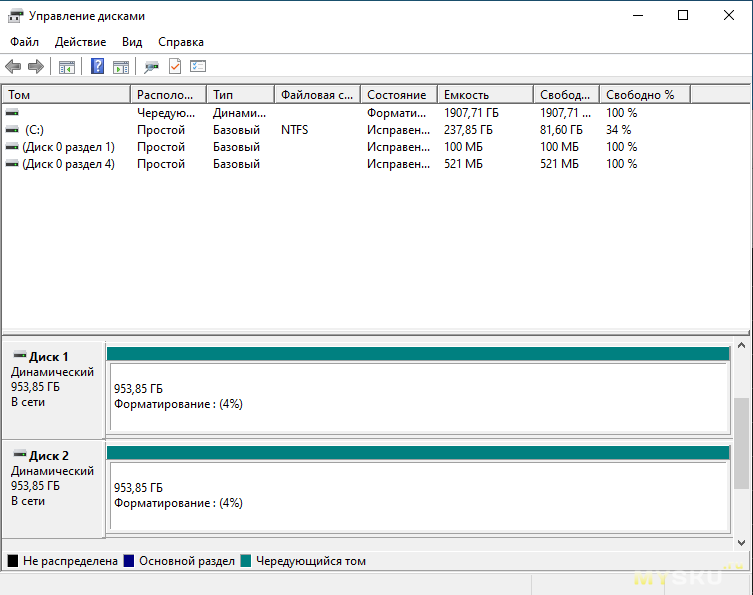

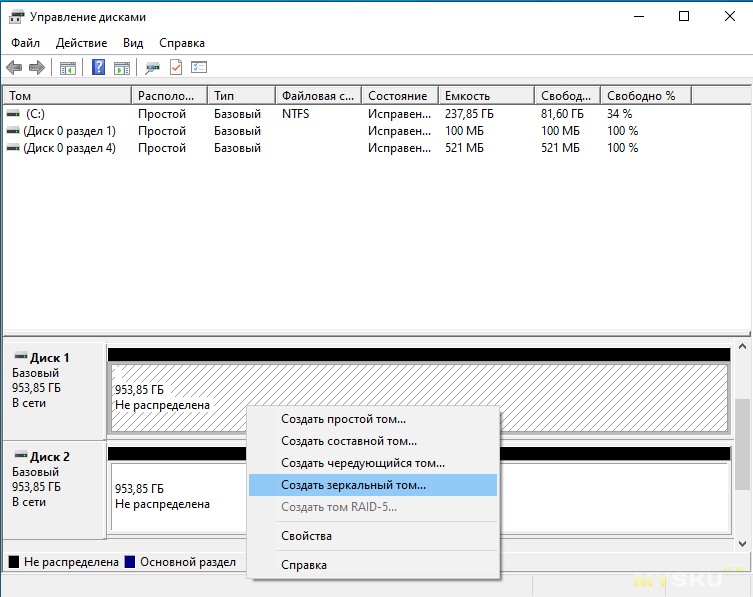

Из-за форматирования после создания составного тома, я не стал демонстрировать другие варианты по составным томам, хотя их не так уж и много:

Из-за форматирования после создания составного тома, я не стал демонстрировать другие варианты по составным томам, хотя их не так уж и много:

После форматирования чередующегося тома, получаем 2ТБ SSD, со скоростями близкими к PCI-E Gen4 x4. Единственное, по работе с мелкими 4К блоками задержка никуда не делась, и скорость таких операций не подросла.

Выводы

Показанный в обзоре адаптер (активный) выполняет заявленные функции, и позволяет практически без потерь в скорости эксплуатировать одновременно два SSD накопителя в одном PCI-E слоту, если материнская плата поддерживает такую возможность.

Единственное, адаптер не поддерживает работу с шиной PCI-E Gen4, но зато имеет весьма демократичную стоимость.

Для корректной работы адаптера требуется поддержка PCI-E Bifurcation со стороны BIOS материнской платы (возможность настройки этого параметра встречается не сильно часто).

Обычно, когда нужно подключить M2 NVMe SSD через PCI-E слот, используется вот такой вот пассивный адаптер с разводкой x4:

Его можно использовать как на древнем компьютере где вообще нет М2 слотов, так и на современном, если одного или двух (бывает не всегда) М2 слотов не достаточно для задач пользователя. Бывают ещё и варианты таких адаптеров, физически выполненные с коннектором x1.

Его можно использовать как на древнем компьютере где вообще нет М2 слотов, так и на современном, если одного или двух (бывает не всегда) М2 слотов не достаточно для задач пользователя. Бывают ещё и варианты таких адаптеров, физически выполненные с коннектором x1.В моём случае, так же можно было использовать такой вариант, когда один SSD работает в М2 NVMe слоту, и второй в таком вот простеньком адаптере, а саму ОС грузить с SATA SSD.

Но вариант использования именно активного адаптера на два SSD сразу, мне видится более интересным, так как его стоимость относительно небольшая (примерно в 2.5- 3 раза дороже пассивного на один SSD), и у меня остаётся возможность задействовать оставшийся свободным М2 NVMe слот при необходимости, а так же, у адаптера есть бонус в виде DC-DC понижаек с 12В (забегаю вперёд), по питанию каждого из SSD, что пригодится мне если я таки смогу реализовать что то вроде самодельного бесперебойника, с основным выходом на 12В, но это уже другая история.

Кроме того, если блок питания используется сомнительного качества, то SSD будут получать более стабильное питание, чем если бы они напрямую сидели на 3.3В от БП.

Распаковка и обзор аппаратной начинки адаптера, для понимания его возможностей.

Приехал адаптер в обычной коробочке, но в данном случае чем дешевле упаковка тем лучше, при условии что она надёжно защищает адаптер при транспортировке.

Внутри коробки находится сам адаптер, 4 винта и две гайки для крепления SSD, два винта для крепления планок, отвёртка, две планки (полноразмерной высоты и укороченная).

Внутри коробки находится сам адаптер, 4 винта и две гайки для крепления SSD, два винта для крепления планок, отвёртка, две планки (полноразмерной высоты и укороченная). Адаптер имеет интерфейс PCI-E x8.

Адаптер имеет интерфейс PCI-E x8.

Контроллер адаптера и DC-DC преобразователи с 12В в 3.3В:

Контроллер адаптера и DC-DC преобразователи с 12В в 3.3В:

Адаптер построен на контроллере SL28PCIE14. В описании к нему сказано что это «PCI-Express Gen 2 & Gen 3 Clock Generator & Fan-out Buffer with EProClock ® Technology». Насколько я понимаю, контроллер содержит 4 тактовых генератора, максимально рассчитанных на работу шины в режиме PCI-E Gen3, и используется данный контроллер видимо для синхронной работы нескольких устройств в рамках одного порта.

Адаптер построен на контроллере SL28PCIE14. В описании к нему сказано что это «PCI-Express Gen 2 & Gen 3 Clock Generator & Fan-out Buffer with EProClock ® Technology». Насколько я понимаю, контроллер содержит 4 тактовых генератора, максимально рассчитанных на работу шины в режиме PCI-E Gen3, и используется данный контроллер видимо для синхронной работы нескольких устройств в рамках одного порта. Т.е даже если вставить этот адаптер в PCI-E Gen4 слот, работать он всё равно будет в режиме Gen3. С PCI-E Gen1 он возможно вообще не заработает (не проверял).

Что касается контроллеров DC-DC преобразователей, я не смог найти информацию о них по маркировке WCCZI.

Как настроить компьютер под корректную работу адаптера?

Предыстория покупки такова, что у меня есть компьютер, построенный на материнской плате JGINYUE TITANIUM D3, которая умеет PCI-E Bifurcation, так как BIOS там сдёрнут с серверной двухсокетной платы. На базе этой платы я планирую строить быструю онлайн хранилку, с использованием ZFS кэширования второго уровня, на NVMe SSD, и ещё кое что интересное.

На плате всего один слот под NVMe SSD, а мне хочется установить именно два таких накопителя. Данная материнская плата имеет хорошее количество PCI-E слотов, способных обеспечить нужные скорости как для двух NVMe SSD, так и для PCI-E Ethernet карты на 10Гбит/c, RAID контроллера (под работу с SAS HDD), так и для видеокарты (так как в процессорах E5 нет встроенной графики, видюха нужна чисто для показа картинки и не более).

Есть у меня и более современный компьютер на базе MSI Z590-A PRO, который я конечно же не планировал использовать под хранилку, но было любопытно поддерживается ли там PCI-E Bifurcation. Ответ — нет. В BIOS нет таких опций, несмотря на то что плата весьма функциональна, и по сути относится к околотоповому сегменту если мы говорим о материнских платах на чипсете Z590.

Вот скриншоты доступных в BIOS настроек:

В BIOS платы JGINYUE TITANIUM D3 настройка PCI-E Bifurcation находится здесь:

Настройки конфигурации портов по умолчанию:

Настройки конфигурации портов по умолчанию: Адаптер рассчитан для подключения в PCI-E слот x8, что логично, так как разведено там 2*4 линии PCI-E.

Адаптер рассчитан для подключения в PCI-E слот x8, что логично, так как разведено там 2*4 линии PCI-E.Устанавливать адаптер я буду в верхний PCI-E слот (x16), материнской платы. В BIOS он обозначается как Port2, его и будем настраивать.

Если выбрать вариант разделения линий внутри слота на пару устройств, по x8 каждая, то адаптер не будет работать корректно. ОС в таком случае увидит лишь один накопитель из двух. Тоже самое будет если вообще ничего не конфигурировать, оставив лишь 16 линий, чисто под одно PCI-E устройство, или установить адаптер в ту же MSI Z590-A PRO.

Если выбрать вариант разделения линий внутри слота на пару устройств, по x8 каждая, то адаптер не будет работать корректно. ОС в таком случае увидит лишь один накопитель из двух. Тоже самое будет если вообще ничего не конфигурировать, оставив лишь 16 линий, чисто под одно PCI-E устройство, или установить адаптер в ту же MSI Z590-A PRO. Для корректной работы адаптера, нужно выставить вариант x4x4x4x4, т.е. разделяя 16 линий на 4 устройства, отдавая по 4 линии на каждое устройство.

Для корректной работы адаптера, нужно выставить вариант x4x4x4x4, т.е. разделяя 16 линий на 4 устройства, отдавая по 4 линии на каждое устройство.

Тесты

Для тестов я взял два NVMe SSD на 1ТБ. В данном случае это Team Group A440 и Team Group MP44 (скоро напишу про них полноценные обзоры).

Не смотря на то что это разные модели, их начинка на 100% одинаковая, даже на их платах написан один и тот же номер.

Не смотря на то что это разные модели, их начинка на 100% одинаковая, даже на их платах написан один и тот же номер.  На вышепоказанном фото, можно видеть что винты вкручены кривовато, так как только в таком положении удалось закрепить накопители, и то не с первого раза, из-за того что продавец положил в комплект слишком короткие винты для крепления SSD.

На вышепоказанном фото, можно видеть что винты вкручены кривовато, так как только в таком положении удалось закрепить накопители, и то не с первого раза, из-за того что продавец положил в комплект слишком короткие винты для крепления SSD.Данные из программы от Вадима Очкина (vlo) по начинке MP44:

Кстати, касаемо программного RAID 1 (зеркало), покрайней мере реализованного средствами Windows 10, то он не гарантирует достоверность данных, он лишь защищает от их потери. Другими словами, данные он отдаст в случае краха одного из накопителей, но вот будут ли это именно те данные что записывались, гарантии нет. Конечно, вероятность такой ситуации что будут отданы искажённые данные крайне мала, но она есть.

Некоторое время назад я проводил эксперемент на виртуалке, изменяя значения данных через WinHex на одном из накопителей, входящих в массив, тем самым эмулируя ситуацию что на двух накопителях находятся разные данные. ОС, (с ФС NTFS), никак это не проверяет, так как такой задачи изначально видимо не ставилось, и сами данные не проверяются на достоверность. Та же ФС ZFS может чекать корректность хранимых данных по запросу.

Ну и собственно пора начать тестирование. Тестировать я буду в программе CDM.

Для начала, убедимся что в диспетчере дисков видны оба накопителя:

В CDI оба SSD определяются корректно (на момент создания скринов, они уже находились в составном накопителе, поэтому у обоих SSD одна и та же буква):

В CDI оба SSD определяются корректно (на момент создания скринов, они уже находились в составном накопителе, поэтому у обоих SSD одна и та же буква): Как видим, Gen4 SSD здесь работают в режиме Gen3 (и материнская плата и активный адаптер поддерживают только Gen3 режим PCI-E).

Как видим, Gen4 SSD здесь работают в режиме Gen3 (и материнская плата и активный адаптер поддерживают только Gen3 режим PCI-E).Проверю скорости в CDM, при работе только одного SSD (второй стоит без нагрузки):

Получившиеся скорости соответствуют потолку возможностей PCI-E Gen3 x4. Такие же скорости наблюдались бы по данному SSD будь он установлен через пассивный x4 переходник, в этот же PCI-E слот материнской платы. Вот такие скорости обеспечивает SSD при работе через пассивный переходник, т.е прямом подключении к PCI-E контроллеру процессора:

Сам SSD может работать существенно быстрее, если дать ему PCI-E Gen4 x4 шину.

Сам SSD может работать существенно быстрее, если дать ему PCI-E Gen4 x4 шину.Скриншот тестов в MSI Z590-A PRO (SSD работает в режиме PCI-E Gen4 x4):

Теперь запущу одновременный тест в CDM (почти одновременно жму кнопку запуска теста по обоим SSD):

Видно, что скорости получились одинаковыми (разница на уровне погрешности), при этом скорости не режутся между накопителями, так как на каждый идёт по 4 выделенных линии PCI-E Gen3. Скорости при одновременной работе двух SSD, аналогичны скоростям когда работал только один SSD из двух, если мы говорим про линейное чтение/запись большими блоками. Случайное многопоточное чтение с очередью (Q32T16) несколько просело (задержки увеличились), но это не так критично.

Видно, что скорости получились одинаковыми (разница на уровне погрешности), при этом скорости не режутся между накопителями, так как на каждый идёт по 4 выделенных линии PCI-E Gen3. Скорости при одновременной работе двух SSD, аналогичны скоростям когда работал только один SSD из двух, если мы говорим про линейное чтение/запись большими блоками. Случайное многопоточное чтение с очередью (Q32T16) несколько просело (задержки увеличились), но это не так критично.Теперь создам ради интереса чередующийся том:

Начинается форматирование дисков, тратящее ресурс SSD:

Начинается форматирование дисков, тратящее ресурс SSD: Из-за форматирования после создания составного тома, я не стал демонстрировать другие варианты по составным томам, хотя их не так уж и много:

Из-за форматирования после создания составного тома, я не стал демонстрировать другие варианты по составным томам, хотя их не так уж и много:

После форматирования чередующегося тома, получаем 2ТБ SSD, со скоростями близкими к PCI-E Gen4 x4. Единственное, по работе с мелкими 4К блоками задержка никуда не делась, и скорость таких операций не подросла.

Выводы

Показанный в обзоре адаптер (активный) выполняет заявленные функции, и позволяет практически без потерь в скорости эксплуатировать одновременно два SSD накопителя в одном PCI-E слоту, если материнская плата поддерживает такую возможность.

Единственное, адаптер не поддерживает работу с шиной PCI-E Gen4, но зато имеет весьма демократичную стоимость.

| +168 |

14679

114

|

| +125 |

11495

82

|

Самые обсуждаемые обзоры

| +278 |

5732

163

|

| +33 |

1856

57

|

А с портами последнее время крайне скудно, ну и зачастую бифуркация доступна только на одном из x16, а там, извините, уже видео.

Кто-то понимает в чем принципиальная проблема сделать устройство поддерживающее 4 диска на x1? Почему китайцы с маниакальным упорством клепают эти недоадаптеры?

это принципиально получается дороже, чем напрямую развести 16 линий от одного разьема к 4м другим в случае поддержки со стороны матери. ибо требует активного переключателя (до кучи он еще и режим ограничивать будет).

тем более что распространение подходящих матерей за последнее время стало выше.

но вспоминая, что 16->4х4 в свое время пассивные были тыщи полторы-две, а активные за десятку, полагаю именно это основная причина, получается банально заметно дороже. особенно вместе с сильно меньшими тиражами в том числе и по причине цены. вопрошавший поди хочет не вообще, а чтоб еще и дешево.

К слову вопрошавший хотел бы наличие какого-то выбора. А в наличии фактически полное отсутствие. Ну или вопрошавший не умеет искать.

активных может и нет уже — в те времена они pcie3 были, сейчас это выглядит немного неактуально.

хотя вот нашелся на PEX 8747:

https://aliexpress.ru/item/1005001626193591.html

Я правда думал что речь про pcie свитч а не про адаптер к m2.

Так что наличие бифуркации будет в амдшных чипсетах, если конечно производитель реализовал его в Биосе ну или в серверных

Для остальных есть вариант похожей платы на pcie-pcie бридже, отличается ценой и здоровенным радиатором на бридже.

Например

a.aliexpress.com/_Ev5ZmvV

Есть такой же но на 4 м.2 диска, стоит примерно 100баксов

На той же китайской мамке где я запустил это чудо, чипсет intel вроде 7 серии.

На тао я кажется видел более демократичные цены на адаптеры под 4 SSD, могу поискать.

Но по каким-то причинам ни на одной современной интеловской десктопной матери это дело не реализовано.

На Тао примерно те же цены. Возможно я не так искал(

Вот интересное чтиво, для маньяков)

linustechtips.com/topic/1463027-say-no-to-the-paywall-of-pci-e-bifurcation/

схренали? z690/790 распрекрасно поддерживают 2x8.

другое дело, что именно первые 8 линий поделить они в принципе не умеют, слот делится на первые 8 и вторые 8. так что именно этот переходник для них бесполезен.

а рассматривать не самые удачные hedt платформы, продававшиеся в штучных количества, смысла немного.

А вот скоростных pcie свитчей я отчего-то не вижу, вот чего я не понимаю. Нет же выбора вот за 100р а вот за 10тыр.

Не требует бифуракции от материнки. Ценник вы видите.

На 4 с нынешним алишным поиском сходу не нашёл, но раньше тоже были.

но правда на входе у нее, судя по ASM2812, всего 3.0x4.

как раз на исходную хотелку, в виде 4шт по x1, прокатило бы. и даже на 6.

Изначально хотелось х1 на материнке задействовать. Или хотя бы х16-х1/х2/4.

Я ж писал что проблема в том что если у вас не серверная материнка, то про х8 можно смело забыть, у вас один x16 в которой уже видео живет, и кучка x1.

В крайнем случае 1-2 x16 в которой х1/х2 а если повезло х4.

И куда совать адаптеры как по ссылке? Некуда.

Я сейчас беру в магазине плату и там картина типа 1х16х16 с возможной бифуркацией, и пара х1.

Толку мне с 8х8 или 4х4х4х4 если там видеокарта?

Есть платы со второй х16 но там уже нет не только х16 но и х8. Максимум х4, а чаще х1/х2. Еще и pcie как правило ниже на поколение (хотя пару исключений нашел). Бифуркации обычно тоже никакой уже нет, и в общем то понятно почему.

Итого с одной стороны куча pcie а с другой рабочий ровно один все прочие разве что для затычек типа сетевой карты. И подобные адаптеры как в топике не сильно помогают. Дичь какая-то на мой взгляд.

Но да, нужно пробовать.

Так SATA в таком адаптере упрется ровно в те же ограничения.

Суть проблемы как я уже понял в жадности производителя MB. Распаивает кастрированные шины.

Почему тогда я написал что может не заработать? Не всегда в пропиленных x1 слотах определяются устройства в принципе. Но это решаемо замыканием контакта device detect.

Остается только в лучшем случае x16x4 а то и х16х2 а там бифуркации нет и больше одного устройства не заведется. Хотя тут скинули пару ссылок, нужно будет попробовать.

Не покупайте ноутбуки ASUS/ACER: там. чтобы очистить ноутбук от пыли. нужно буквально ноутбуки полностью разбирать! Наш выбор — LENOVO!

а «аккум на очереди» намекает на древность модели.

но эта плата умеет в чипсетный RAID двух NMVe дисков, за счет резанья SATA разъемов до 3 штук. На днях на этой плате один из двух WD SN700 в RAID1 учудил (определился после выключения питания) и так что непонятно куда бежать за надежностью в российской рознице.

В общем, впечатления пока только положительные.

Т.к. Вы хотите к дискам и сеть на 10G, то надо как-то определить, на что способны сами железки в этой связке под разными ОС и с разными ФС (или делить на разные ФС по типам нагрузки). Мне кажется, что ZFS больше про надёжность, а не про скорость.

На своём текущем конфиге при записи я уже упираюсь в винты, а при чтении в сеть. Но у меня домашняя лаба, l2arc и zil дополнительно не настраивал, на большее я пока не претендую.

так описанное и не является особенностью данной реализации.

целостность данных должен обеспечивать сам накопитель. зеркало нужно для ликвидации простоя в случае отказа одного из накопителей, не более.

Это был доступный накопитель nmve на момент покупки в августе 2023 года который типа позиционировался для сервера. Сейчас купить такой же 1 Тб это только из Китая.

Вы бы ещё КПК предлагали модернизировать…

Пруф

а то что мс впаривает свою очередную дичь не удивляет. иначе ее вообще не заметят.

Адаптер поддерживает загрузку операционной системы с SSD?

Как ещё ничего в ссд не закоротилось медными вставками на плате переходника?)

Болтики у него короткие, блин!

*

Посмотрел внимательно фото комплекта, скорее всего тут второй вариант:

Втулка ставится на плату переходника сверху (со стороны диска), крепится болтиком сзади через плату. Сверху ложится ssd и прикручивается вторым болтиком. Потому они и короткие!

Может в стационарном варианте может и не мешает, поскольку тяжелый системник никто не двигает. А вот когда это переходник m2-USB и оно болтается в кармане, выдавая стремные звуки?

От того что ситуация лично вас устраивает, косяк никуда не делся.

Переходник M2 NVME PCIE без бирфускации

другое дело что uefi там все равно не будет.

У меня X79 с такого диска грузила десятку.

Если у гигабайта, или не у гигабайта а у других производителей есть для материнок на вашем чипсете биосы с поддержкой NVME + у вас UEFI биос, то можно подкинуть дрова контроллера NVME, иначе не судьба.